Nem csak a munkát, az áramot is elveszi – Egyre fenyegetőbb az AI energiaéhsége, amit velünk fizettethetnek meg a cégek

A mesterséges intelligenciát gyakran tisztán digitális jelenségnek tekintjük, amely a bitek és algoritmusok megfoghatatlan szintjén működik, de valójában minden egyes AI-val generált kép, vagy ChatGPT-ben keletkezett válasz mögött mérhető energiafogyasztás áll. A háttérben hatalmas szerverközpontok dolgoznak, amelyek ásványi anyagokból készült chipekkel és félvezetőkkel teli számítógépparkokat működtetnek – és ehhez jelentős mennyiségű villamosenergia kell. Amennyiben tehát az AI fejlődését és terjedését vizsgáljuk, a számítástechnikai kihívások mellett figyelembe kell venni az infrastrukturális és ökológiai korlátokat is.

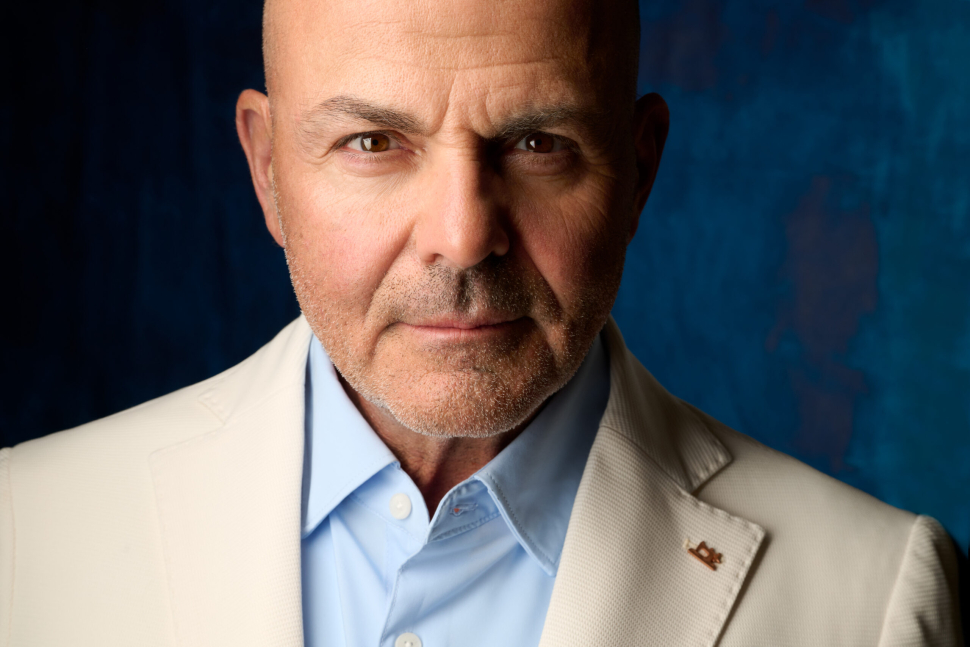

Bármennyire ígéretes az AI, a növekedésének van egy nagyon is kézzelfogható határa, amire Sam Altman, az OpenAI vezérigazgatója nemrég egy kongresszusi meghallgatáson világított rá. Mint mondta, „idővel a mesterséges intelligencia költsége össze fog érni az energia költségével”.

Altman a Time szerint arról is beszélt, hogy hiába válnak egyre automatizáltabbá és olcsóbbá a chipgyártási és hálózati folyamatok, egy elektron energiaigénye akkor sem lesz kisebb, vagyis a számítási feladatok fizikai energiaigénye adott, és nem csökken zéró alá. Végső soron tehát egy érett AI-gazdaságban az „intelligencia” előállításának határköltsége megközelíti az elektromosság határköltségét.

A forradalmi AI-termékeket fejlesztő cég vezetője világossá tette: az energetikai innováció és az AI képességei között közvetlen kapcsolat keletkezik, így azok a régiók, amelyek bőségesen, megbízhatóan és olcsón tudnak energiát biztosítani, döntő előnyre tesznek szert a számítási kapacitás terén.

Energiakorlátok: lesz-e elég áram az AI-hoz?

Az, hogy az innováció egyik kulcsa az energia, már napjainkban is tetten érhető. Egyes becslések szerint csak az Egyesült Államoknak akár további 90 gigawatt teljesítményre – tehát pluszban nagyjából 60 paksi atomerőműre – lenne szükség az adatközpontok ellátásához a következő években. A City Journal szerint Altman ezért figyelmeztetett arra, hogy az energiaellátás fejlesztése a legfontosabb stratégiai beruházás. „Nem jut eszembe semmi, ami hosszú távon fontosabb lenne, mint az energia” – fogalmazott az amerikai szenátus energiaügyi bizottsága előtt.

És Kína már most globális vezető szerepben van a megújuló energia területén, ráadásul az évtized végére a világ teljes megújuló kapacitásának közel felét birtokolhatja majd. Jól látszik, hogy az AI-verseny könnyen energiaversennyé alakulhat: az nyer, akinek több és tisztább energiája van az AI rendszerek üzemeltetésére.

És ennek hatása a mindennapokban is érezhető lesz – jósolta a BloombergNEF, Elon Muskra hivatkozva. A robotikai és AI-forradalomra készülő Tesla-vezér nyilatkozata szerint „jelenleg chiphiány van, egy év múlva transzformátorhiány, két év múlva pedig áramhiány lesz”. Mark Zuckerberg szintén tett erre utaló jelzést, amikor nemrég kijelentette: a Meta azonnal nekilátna több adatközpont építésének, ha kapna hozzá elegendő villamosenergiát.

A világ legnagyobb adatközpontjainak otthont adó Észak-Virginiában a szerverparkok már kb. 2,5 gigawatt kapacitást kötnek le, ami a térség áramszükségletének kb. 20 százalékát jelenti, és a szakértők arra számítanak, hogy az igények évi 25 százalékkal nőnek. Pedig már 2022-ben (a ChatGPT szabadon engedése előtt) előfordult, hogy egy helyi áramszolgáltató átmenetileg kénytelen volt leállítani az új adatközpontok hálózatra kapcsolását, mert nem tudta garantálni az ellátásukat. Hasonló helyzet állt elő Írországban, ahol a Dublin környéki adatközpontok – szintén 2022-ben – felemésztették az ország teljes áramfogyasztásának 21 százalékát – szemben a 2015-ös öt százalékkal. Itt a hatóságok moratóriumot hirdettek új adatközpontok létesítésére.

A példák jól jelzik: könnyen előfordulhat, hogy a hagyományos hálózatfejlesztés nem tud lépést tartani az AI-központok energiaigényével.

Ugrásszerű növekedés indult, a tettes az AI

A mesterséges intelligencia széleskörű használata miatt az elmúlt években érezhetően megugrott az emberiség energiaigénye. A fordulópont 2020 körül érkezett el: egy évtizednyi viszonylagos stagnálás után az adatközpontok villamosenergia-igénye hirtelen növekedésnek indult, egyrészt az AI modellek szaporodása, másrészt pedig a COVID-időszak távmunkatrendje miatt. A fogyasztás meredeken emelkedni kezdett, leginkább a szerverparkok növekvő igénybevételének köszönhető.

Az amerikai Környezet- és Energiakutató Intézet becslései szerint az adatközpontok áramfelhasználása már 2022-ben elérte a 176 terawattórát az Egyesült Államokban (ami több mint kétszerese a néhány évvel korábbinak), miközben a globális adatközpontok energiafelhasználása 460 TWh lehetett. Az MIT riportja összehasonlításképpen azt írja, ha az adatközpontok önálló országot alkotnának, akkor már az AI jelentősebb térnyerése előtt, 2022-ben a világ 11. legnagyobb áramfogyasztójának számítottak volna, pedig ez sehol sincs a jelenlegi áramfelhasználáshoz képest.

Ez őrületesen gyors változás. Amerikai példával érzékeltetve: az AI-ra specializált szerverek éves fogyasztása 2017-ben még alig két terawattóra volt, 2023-ra viszont már elérte a 40 terawattórát, ami hússzoros növekedés – úgy, hogy csak a ChatGPT 2022-es megjelenését követő egyetlen év alatt megháromszorozódott az energiafelvételük.

Mit mutatnak az előrejelzések 2030-ra és 2040-re?

A fentebb írt tendencia folytatódni látszik, ami az évtized végére sokkoló mértékű energiaigényt jelez előre. A Nemzetközi Energiaügynökség (IEA) elemzése azt mutatja, hogy a globális adatközpontok villamosenergia-fogyasztása 2030-ra a jelenlegi több mint a kétszeresére nő, és eléri a 945 terawattórát.

De menjünk még tovább a belátható jövőben: a Rystad Energy nemrég közzétett előrejelzése 2040-re már közel 1800 terawattóra fogyasztást vetít előre – ez nagyjából annyi energia, amennyivel 150 millió amerikai háztartást lehetne ellátni, egy teljes éven át.

Verseny az energiaforrásokért: merre tovább?

Az előttünk álló legnagyobb kihívás az, hogy milyen energiaforrásokkal és hogyan tudjuk kielégíteni az AI által gerjesztett plusz igényt. A jelenlegi trendek alapján a villamosenergia előállításának diverzifikációjára elengedhetetlennek tűnik. Az IEA azt látja, hogy az adatközpontok növekvő áramszükségletét számos forrásból fedezheti a világ, és ebben főszerepet játszhat a szél- és napenergia mellett a földgáz is, hiszen ezek költséghatékonysága és elérhetősége igen kedvező a kulcspiacokon. Fontos megjegyezni ugyanakkor, hogy a megújulók termelése még mindig erősen időjárásfüggő, így sokan fordulhatnak majd az atomenergia felé.

A Goldman Sachs elemzői ezzel kapcsolatban azt írják, hogy 2030-ig globálisan 85–90 GW új nukleáris kapacitásra lenne szükség ahhoz, hogy az adatközpontok várható többletigényét teljes mértékben atomenergiával fedezzük. Reálisan azonban ennek csak a töredéke épül meg: a riport szerint világszinten a szükséges atomkapacitás kevesebb mint tíz százaléka áll majd rendelkezésre az évtized végére.

Rövid távon tehát valóban a földgáz és a megújulók kombinációja töltheti be a tátongó űrt. Egy iparági felmérés kimutatta: megfelelő energiatárolással (vagyis akkumulátorokkal kiegészítve) a szél- és napenergia egy adatközpont igényének 80 százalékát is fedezheti, viszont a fennmaradó időre (amikor például nem süt a nap vagy szélcsend van) hagyományos energiaforrásokra van szükség a folyamatos ellátáshoz.

A jelenlegi trend azt mutatja, hogy sok új adatközpont – főleg Ázsiában és Észak-Amerikában –földgáztüzelésű erőművekhez csatlakozik, mivel ezek tudják azonnal kiszolgálni a gyorsan növekvő igényeket. A hagyományos megoldásnak ugyanakkor ára van: ha a globális adatközpont-kapacitás bővülését 60 százalékban földgázerőművek biztosítják, az évente további 215 millió tonna karbonkibocsátást jelentene 2030-ra, ezzel a világ energiaipari emissziójának kb. 0,6 százalékát adná.

Sorra vásárolják fel az atomenergia-kapacitásokat

A techcégek felismerték a helyzet komolyságát, és már most jelentős lépéseket tesznek az energiaellátás biztonságáért. A legnagyobb felhőszolgáltatók (mint a Google, az Amazon, a Microsoft vagy a Meta) a világ legnagyobb zöldenergia-vásárlói közé léptek: összesen több mint 70 gigawatt kapacitásra kötöttek hosszú távú áramvásárlási szerződéseket. A BloombergNEF szerint az is jól látható trend, hogy a tiszta, folyamatos ellátás reményében a vállalatok újra az atomenergia felé fordulnak.

A Microsoft például nemrég szerződött a hírhedt (1979-ben súlyos reaktorbalesetet szenvedett, majd 1985-2019-ig működő) Three Mile Island atomerőmű 2027-28-as újraindítására, hogy aztán a teljes termelését az adatközpontjai üzemeltetésére fordítsa, míg az Amazon 2023-ban úgy, ahogy van, megvette egy pennsylvaniai atomerőmű melletti adatközpont teljes kapacitását, a Google pedig rendelt hét darab kis moduláris reaktort.

A hosszabb távú megoldást sokan a technológiai áttörésektől remélik. Az összes energiaforrás turbófokozatra kapcsolása mellett megjelent az igény az innovációra, így a fúziós energia ígérete is egyre többeket vonz. Altman személyesen is befektetett például a Helion nevű fúziós startupba, amellyel a Microsoft ugyancsak megállapodást kötött. Ez a cég 2028-ra ígéri, hogy az első kísérleti fúziós erőműve már képes lesz áramot termelni.

Az AI energiafogyasztását a lakossággal és a kisfogyasztókkal fizettethetik meg

Az energiaigény növekedése – amennyiben a kínálat nem tart lépést az igényekkel – óhatatlanul az árak emelkedéséhez vezet. Az Egyesült Államok Elnöki Hivatalának Gazdasági Tanácsa (CEA) nemrég kiszámolta: ha nem történik kellő volumenű beruházás az energiatermelésbe, 2030-ra az áramárak 9–58 százalékkal nőnek a megnövekedett kereslet miatt. Ez a Fox Business elemzése alapján minden fogyasztót érinteni fog.

A kiemelkedően sok áramot használó vállalatok – mint az AI-központok – mindazonáltal szintén magasabb díjat fizethetnek majd, hogy finanszírozzák a hálózatfejlesztést, de ezeket a plusz terheket aligha akarják benyelni. Félő, hogy a vállalatok megemelkedett költségei rejtve maradnak vagy szétterülnek, és végső soron a háztartások és kisfogyasztók viselik majd az AI energiaéhségének terheit. Mark Wolfe, az amerikai Nemzeti Energiatámogató Igazgatók Szövetségének ügyvezetője a CBS Newsnak azt mondta, „a szolgáltatók versenyt futnak az egekbe szökő AI- és felhőigények kielégítéséért, ezért új infrastruktúrát építenek majd és emelik a díjakat – gyakran bármiféle átláthatóság és lakossági beleszólás nélkül.

A következő években tehát várhatóan nőni fog az energiaár a mesterséges intelligencia térnyerése miatt, akár közvetlenül (a felhőszolgáltatások drágulása révén), akár közvetetten (a villamosenergia árában realizálódva). Ebbe az irányba mutat az is, hogy sok vállalat már most jelentős összegeket költ AI-infrastruktúrára: a City Journal szerint a legnagyobb tech cégek 2023-ban kb. 300 milliárd dollárt fordítottak AI-adatközpontokra világszerte, és ez az összeg 2030-ra elérheti az évi ezermilliárd dollárt is. És minden 100 milliárd dollárnyi új adatközpont-beruházás nagyjából ugyanekkora összegű energiaszámlát jelent évtizedes távlatban. Ebből világosan kitűnik, hogy az energiaköltség az AI költségének meghatározó elemévé válik.

Ha az AI miatt trillió dolláros nagyságrendben kell beruházni új erőművekbe és hálózatfejlesztésbe, az valószínűleg megjelenik az adókban vagy az energiaárakban. Ezáltal joggal merül fel az aggodalom, hogy a cechet a háztartások fizetik meg, miközben a hasznot a nagy technológiai cégek fölözik le. A társadalmi igazságosság szempontjából kérdés, hogy helyes-e az általános energiaár-emelkedés terhére kielégíteni az AI energiaigényét. További aggály, hogy az energiaellátás javára esetleg más területektől (pl. oktatás, egészségügy) vonnak el erőforrásokat – legalábbis abban az esetben, ha a kormányok mindent az energiabővítésnek rendelnek alá.

Mit érzékelnek a felhasználók az AI energiaéhségéből?

Jelenleg szinte semmit. Amikor valaki beír egy kérdést a ChatGPT-be, nem látja, hogy a válasz mögött mennyi áram ég el – és az átlagfelhasználó erre nem is gondol. Pedig egy MIT-kutatás szerint egy ChatGPT-lekérdezés nagyjából ötször több elektromos energiát használ el, mint egy egyszerű Google-keresés. A különbség oka az, hogy az AI-modell párhuzamos számításokat végez a válasz generálásához, ami több processzort és ezáltal több energiát mozgat meg. Ez ugyanakkor a háttérben történik, így a felhasználó ugyanúgy egy pár másodperces választ lát a képernyőn, mintha csak egy keresést indított volna. Az energiafogyasztás ezen a szinten tehát rejtve marad.

Közvetetten azonban a felhasználók is találkozhatnak az AI energiaéhségének hatásaival. Ahogy fentebb fejtegettük, a villanyszámlák emelkedése vagy az energiaszolgáltatók új díjszabásai mögött részben az áll, hogy ki kell szolgálni az adatközpontok igényeit. Ha az energiaárak jelentősen nőnek, az hat a gazdaság minden területére – így a digitális szolgáltatások beárazására is. Elképzelhető tehát, hogy idővel az ingyenesen vagy olcsón használt AI-alkalmazások díjkötelessé válnak vagy drágulnak, hogy a szolgáltatók fedezni tudják az energiaköltségeket.

David Cahn, a Sequoia Capital partnere kiszámolta, hogy a nagy AI-beruházások megtérüléséhez globális szinten akár évi 600 milliárd dollárnyi bevételt kellene termelni az AI-szolgáltatásokból – ami fejenként nagyjából 600 dolláros (több mint 200 ezer forintos) éves kiadást jelentene az egymilliárd legjobban kapcsolódó felhasználó számára.

Az energiakínálat bővítése és az energia-infrastruktúra fejlesztése tehát nem pusztán az AI energiaéhségének kiszolgálása, hanem befektetés is a jövőbe. Ha sikerül fenntartható módon kielégíteni a növekvő energiaigényt, az megalapozza a mesterséges intelligencia további fejlődését és az abból származó előnyöket. Az emberiség olyan produktivitási és innovációs ugrást érhet el, ami felgyorsíthatja a gazdasági növekedést és számos problémára megoldást kínálhat. A technológia egyik legígéretesebb hozadéka összességében a nagyarányú termelékenységnövekedés lehet – ami minden gazdaságban a hosszú távú jólét kulcsa.