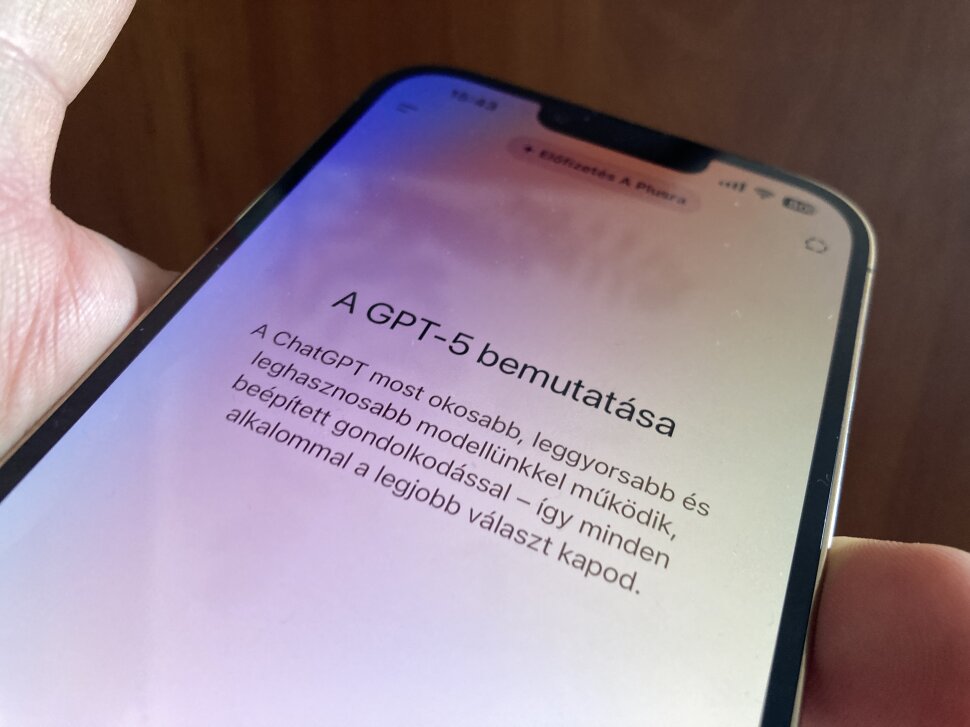

Egy csapásra felnőtt a ChatGPT – Az új nyelvi modell korszakváltást hoz, de vajon ki irányít kit?

A Cinikus, a Robot, a Hallgató és a Kocka - akár egy Guy Ritchie-film címe is lehetne, de ezek a ChatGPT új személyiségei, amelyek a GPT-5-tel egy ütemben jelentek meg. Az új nyelvi modell (LLM) talán legnagyobb erénye ugyanakkor messze nem az, hogy többféle stílusban kommunikál, hanem az, hogy például megbízhatóbb válaszokat ad, miközben a fejlesztők szerint sokkal jobban ír és kódol, mint a korábbi verziók.

Az OpenAI nemrég kiadta a GPT-5-öt, amely a cég szerint sokkal gyorsabb és kompetensebb, mint az eddigi nyelvi modellek. A hatalmas frissítés megjelenése feltehetőleg annak köszönhető, hogy az úttörő vállalatot egyre jobban szorongatja a konkurencia. A verseny fűti a fejlesztést, sürgeti az újabb és újabb képességek beemelését, de közben nem csitulnak a kritikák a mentális egészség romlásával és a munkahelyek potenciális megszűnésével kapcsolatban. Sam Altmanék az utóbbi két aggodalomnak legalább az egyikére igyekeznek megnyugtató választ adni a GPT-5-tel.

Az OpenAI vezetői már 2024-ben utalgattak rá, hogy a cég dolgozik az új nyelvi modellen. A vezérigazgató akkor „tudományos bizonyossággal” állította, hogy a GPT-5 okosabb lesz a GPT-4-nél, amelyről egy korábbi beszélgetésben egyébként nyersen azt mondta, „elég vacak”. A Windows Central emlékeztet: Altman azt is előrevetítette, hogy a GPT-5 már „virtuális agyként” fog működni, mélyebb gondolkodási képességekkel ruházzák fel, és még nála is okosabb lehet bizonyos területeken. Az OpenAI kutatási vezetője, Jerry Tworek később úgy fogalmazott, hogy „a GPT-5 alapmodell célja az, hogy mindent jobban csináljon, amire a jelenlegi modelljeink képesek”. Rendben, de vajon összejött?

Az OpenAI szintén elég magabiztosnak tűnik az innovációjával kapcsolatban, hiszen az ingyenes felhasználók számára rögtön elérhetővé tette az LLM-et. Az előfizetők jelentős része ehhez képest várni kényszerül: a bemutató napján csak húsz százalékuk kapta meg azonnal a GPT-5-öt, míg a többieknél fokozatosan, néhány nap leforgása alatt kapcsolják be. Ezzel a lépéssel először kerül sor arra, hogy egy csúcsmodellhez nem csak a díjcsomaggal rendelkezők férnek hozzá, hanem globálisan akár 700 millió ember – többségében olyanok, akik nem fizetnek a ChatGPT használatáért.

All-in-one nyelvi modell született

A GPT-5-tel alapvetően az volt az OpenAI szándéka, hogy egységesítse és felturbózza az eddigi GPT-modellek képességeit. A cég az új, „sok az egyben” nyelvi modellt és a nehezebb feladatokra szánt „gondolkodó” modellt szorította bele egyetlen rendszerbe. Ez a gyakorlatban azt jelenti, hogy a ChatGPT felületén a GPT-5 egyetlen modellként jelenik meg a felhasználók számára, magyarán nincs külön GPT-4 és külön érvelő verzió, amelyek között a felhasználók kapcsolgatnak, hanem a háttérben egy ún. „router” döntést hoz róla: az adott kérdésre az a jobb megoldás, ha kisebb modell ad egy gyors, felületes választ, vagy az, ha mélyebb elemzésbe kezd a nagyobb, alaposabb modellel.

A The Verge példája szerint mindenesetre meg lehet trükközni: ha a felhasználó azt kéri a GPT-5-től, hogy „alaposan gondold át” a választ, akkor a rendszer automatikusan hosszabb futtatást indít, ezzel a válaszok egyszerre lehetnek gyorsabbak és okosabbak.

Az OpenAI azt állítja, jelentős előrelépéseket ért el a GPT-5-tel az eddigi problémák kiküszöbölésében és a gyakori feladatok továbbfejlesztésében. A fejlesztők a vállalat blogjában arról írnak, hogy sikerült drámaian csökkenteni a „hallucinációkat”, vagyis a válaszokban elő-előforduló kitalált, téves információkat, de javult az utasítások pontos követése és mérsékelték a modell hajlamát a túlzott egyetértésre.

Mégis, miben jobb a GPT-5?

Sam Altman egy sajtótájékoztatón azt mondta, hogy a GPT-5 az első nyelvi modell, amitől tényleg bármit kérdezhetünk, mert „legitim, PhD-szintű szakértőként” viselkedik. A vezérigazgató szerint „az egyik legmenőbb dolog, hogy azonnal jó szoftvert ír”, hiszen az igény szerinti szoftverek alkotása „a GPT-5 korszak egyik meghatározó jellemzője lesz”.

A cég azt állítja, hogy a modell kiválóan működik szövegíró partnerként is, mivel képes akár irodalmi igényű, gördülékeny szövegek alkotására, és a nehéz nyelvi feladatokkal szintén jobban elboldogul, mint az elődei, sőt, olyan kreatív kihívások sem okoznak gondot neki, mint a bonyolult narratívák szerkesztése. Ide tartozik még az, bár napjainkban erre már inkább elvárható minimumként tekintünk, hogy a ChatGPT mostantól hatékonyabban segíthet a mindennapi írásos teendőkben (például e-mailek és jelentések megfogalmazásában), és teszi mindezt koherensebb, választékosabb stílusban.

Az OpenAI hozzáteszi: az új nyelvi modell további előnye az, hogy „messze a legjobb egészségügyi válaszadó”. A cég saját HealthBench tesztjén (amely valósághű orvosi szcenáriókat tartalmaz) a GPT-5 jelentősen magasabb pontszámot ért el a korábbi változatoknál. Ha minden igaz, ezzel kipipálhatják, hogy a GPT-5 már aktív gondolkodó partner az egészségügyi témákban: proaktívan felhívja a figyelmet potenciális problémákra, pontosabb és megbízhatóbb válaszokat ad, és jobban alkalmazkodik a felhasználó egyedi kontextusához, például az előzetes ismereteihez vagy a lakóhelye földrajzi adottságaihoz.

A vállalat egyértelművé tette, hogy a GPT-5 fejlesztése során a korábbi hiányosságok orvoslása és a biztonság javítása kulcsfontosságú szempont volt, mivel a korábbi modellek kapcsán rengeteg aggály merült fel, a visszaélésektől a félretájékoztatáson át a valóság torzításáig.

Előfordult, hogy a modell magabiztosan javasolt például nem létező orvosi ajánlásokat vagy álinformációkat, ami akár súlyos következményekkel is járhatott, ha egy-egy felhasználó túlságosan megbízott benne. Ugyanígy gondot okoztak politikai és vallási témájú beszélgetések: a ChatGPT-3.5 és GPT-4 modelleket sokan vádolták elfogultsággal, mondván egyes világnézeteket előnyben részesítenek, másokat cenzúráznak, és olykor sértő vagy bántó tartalmakat is közvetítenek.

A GPT-4-et különösen sok kritika érte, amiért túl készségesen megerősít akár hamis vagy problémás felvetéseket, ahelyett, hogy ellentmondana. Ez a „túlságosan engedelmes” viselkedés néhány esetben erősítette a felhasználók tévképzeteit. A The New York Times például nemrég arról számolt be, hogy a túl engedékeny ChatGPT egyes felhasználóknál támogathatta téveszmék kialakulását, sőt, súlyosbíthatott mentális kríziseket. Mondjuk ezzel ellentétes tapasztalatok is akadtak, amikor egy kutatás során bebizonyosodott: a nyelvi modellek alkalmasak lehetnek rá, hogy tartósan meggyőzzék az összeesküvés-hívőket a konteók ellenkezőjéről.

További fontos tanulság, hogy a korábbi GPT-k biztonsági okokra hivatkozva hajlamosak voltak kategorikusan megtagadni bizonyos kérdések megválaszolását, ami persze érthető törekvés, de a jó szándékú felhasználókat is frusztrálta. Ilyenek voltak egyes egészségügyi, vallási vagy politikai és bűnügyi témák, amelyekre a ChatGPT-4 és 4o gyakran sablonos elutasítással felelt, ha úgy ítélte meg, hogy a beszélgetés érzékeny terepre tévedt. Az OpenAI belátta, hogy ez hosszú távon rontja a felhasználói élményt és a modell hitelességét, ezért a GPT-5-ben már új megközelítést vezettek be, az ún. „biztonságos befejezést”.

Ennek lényege az, hogy a modell nem némul el teljesen egy-egy kényes kérdésnél, hanem a biztonságos keretek betartásával próbálja létrehozni a lehető leghasznosabb választ. A felhasználó így kap valamennyi információt, de a modell ügyel rá, hogy ne szolgáltasson konkrét receptet valamilyen károkozáshoz, például félrevezetéshez vagy bűncselekmény elkövetéséhez.

Mekkora lépés előre a GPT-5?

A Reuters a rend kedvéért felhozza, hogy a GPT-5 bevezetését nem pusztán a felhasználók kegyeiért indult ádáz verseny és az innováció iránti igény indokolta, hanem néhány technikai nehézség is. Az OpenAI a GPT-4 után szembesült azzal, hogy a korábbi recept – azaz a modellek duzzasztása még több adattal és számítási kapacitással – már nem elégséges. Ennek egyrészt az az oka, hogy fogytán van az online elérhető és érdemben felhasználható tréningadat, másrészt pedig az, hogy a hatalmas modellek betanítása egyre nehézkesebb, hiszen a több hónapig tartó betanítás során bármikor felléphet hiba, ráadásul csak a folyamat végére derül ki, hogy mennyire hatékony az a modell, aminek a létrehozásába rengeteg időt, pénzt és energiát öltek. Az OpenAI ezért vezette be a GPT-5 „gondolkodó” módját, vagyis azt, hogy a modell a futtatás során képes extra erőforrást igénybe venni a bonyolult feladatokhoz.

Az OpenAI vezetői egyértelművé tették, hogy rendkívül jelentős evolúciós ugrásként tekintenek a GPT-5-re. Sam Altman szemléletes hasonlattal úgy írta le a fejlődést, hogy a GPT-3 még egy gimnazista volt, akivel jót lehet dumálni, viszonylag jó válaszokat ad, de akár teljes sületlenségeket is állíthat, míg a GPT-4 már inkább egy értelmesen érvelő egyetemistához hasonlított. Hozzájuk képest a GPT-5 az első olyan modell, amivel beszélgetve az az érzésünk támad, hogy tapasztalt szakértővel van dolgunk, és közel jár ahhoz, amit általános mesterséges intelligenciának (AGI) nevezünk.

Nem mind arany…

Természetesen nem mindenki látja olyan rózsásan a helyzetet, mint Altman és az OpenAI többi fejese. Már a GPT-5 első bemutatója után akadtak külső szakértők, akik szerint a GPT-5 fejlődése nem feltétlenül nagyobb ugrás a GPT-4-hez képest, mint amekkora a GPT-4 volt a GPT-3.5-höz viszonyítva. Két korai tesztelő a Reutersnek nyilatkozva elmondta, hogy bár lenyűgözte őket a GPT-5 kódíró és komplex feladatmegoldó képessége, úgy érezték, a GPT-4-ről GPT-5-re történt előrelépés nem volt annyira óriási, mint a korábbi generációváltások. Ezt a véleményt erősíti, hogy a nyelvi modellek standard tesztjein (mint amilyen például egyes matematikai vagy tudásfelmérő versenyek szimulációja) a GPT-5 gyakran csak néhány százalékpontos javulást ért el a GPT-4-hez képest – hívja fel a figyelmet a The Register.

Azt mondjuk maga Altman is hangsúlyozta, hogy a GPT-5 nem váltja ki az emberi tudást és ítélőképességet, annak ellenére sem, hogy sok tekintetben már-már emberi szintű kompetenciát mutat. „Ez még nem az a modell, ami önállóan tanul és teljesen kiváltja az embert” – szögezte le, egyértelművé téve, hogy bár az OpenAI forradalmi lépcsőfoknak tartja a GPT-5-öt, egyáltalán nem állítja, hogy célba értek volna az AGI felé vezető úton.

Az OpenAI igyekszik megtalálni az egyensúlyt aközött, hogy a modell a lehető leghasznosabb legyen, de közben felelősen működjön. Azt a cég szakemberei is tudják, hogy magasra került a léc. „Az eddigi tudásunk alapján igyekeztünk a lehető legbiztonságosabb modellt alkotni… Nem vagyunk benne biztosak, hogy mindenben igazunk van, de tudjuk, hogy az AI át fogja alakítani a világunkat, ezért már korán át kell gondolnunk a hasznát, illetve az általa előidézett változásokat és kockázatokat” – fogalmazott közleményben az OpenAI.

A Cinikus, a Robot, a Hallgató és a Kocka

A GPT-5 bevezetésével az OpenAI egy izgalmas új funkciót is bemutatott: négy előre beállított ChatGPT „személyiséget”, amelyekkel a felhasználó testre szabhatja a chatbot hangnemét és stílusát. A használatuk teljesen opcionális: a felhasználó a beállításokban bármikor kiválaszthatja vagy kikapcsolhatja őket – és bármelyik üzenetváltást új stílussal kezdheti. Fontos kiemelni ugyanakkor, hogy a személyiség nem változtat a modell tudásán vagy képességein, csak a válaszok tálalásának módja lesz más és más.

A Cinikus például szarkasztikus és száraz humorú stílus, és bár nyersen, viszont szellemesen válaszol. Nem bunkó, de „tiszteletlenül őszinte” – jellemzi az OpenAI, hozzátéve, hogy a személyiség görbe tükröt tart a kérdezőnek, és olykor csípős megjegyzésekkel illeti. A hangnem ellenére lényegre törő, praktikus tanácsadóról van szó. Ezt a stílust azoknak találták ki, akik szeretik a karcos humorral fűszerezett, de használható válaszokat.

A Robot egy precíz, gépszerűen tárgyilagos hangnem, érzelmek és humor, illetve felesleges szószaporítás nélkül válaszol. Előbb kimondja a lényegi választ tömören, utána maximum rövid magyarázatot fűz hozzá. Hajlamos listázni a tényeket, miközben hivatkozásokat vagy számadatokat is megad, ha szükséges. Ideális, ha a felhasználó gyors, egyenes és félreérthetetlen utasításokat vagy információt kér, érzelemmentes, formális stílusban.

A Hallgató a fentiekhez képest melegszívű, laza és empatikus hangvételben kommunikál. Nyugodtan és együttérzően reflektál a felhasználó gondolataira. Ez a stílus segít átrágni a döntési helyzeteket: rámutat a különböző lehetőségek előnyeire-hátrányaira, és nyitott kérdésekkel ösztönöz, hogy az ember maga jöjjön rá a megoldásra.

A Kocka játékos és tudásközpontú stílus: lelkesen magyaráz el mindent, miközben ünnepli a tudást és a felfedezést. Ez a személyiség mély, de közérthető magyarázatokat ad, imád belevágni a részletekbe, de figyel arra, hogy a válasz érthető maradjon. Gyakran bátorít további kérdésekre vagy kísérletekre, mert az a célja, hogy a felhasználó is lelkesen tanuljon új dolgokat. Akkor a legjobb választás, ha a felhasználó tanárszerű, részletes válaszokra vágyik, esetleg egy tudományos témát akar megérteni.

Az új személyiségek célja elsősorban a felhasználói élmény testreszabása és a fentebb írt szervilizmus csökkentése. Az OpenAI szerint ezek a profilok segítenek, hogy a ChatGPT ne mindig ugyanabban a „semleges, udvarias asszisztens” hangnemben szólaljon meg, hanem igazodjon a felhasználó preferenciáihoz

Milyen új veszélyforrásokat hordozhat a GPT-5?

Miközben a GPT-5 óriási lehetőségeket rejt, a szakértők azt is hangsúlyozzák, hogy egy ilyen képességű modell esetében új típusú kockázatokkal szintén számolni kell. Paradox módon épp az teszi veszélyessé, ami az erőssége: hogy még okosabb, meggyőzőbb és szélesebb körben hozzáférhető.

Sam Altman elismerte, hogy a fejlett generatív AI-technológia visszaélésekre adhat lehetőséget. A The National a vezérigazgató egyik interjújából idézve azt írja, Altman rémálmaiban rendszeresen feltűnik, hogy a ChatGPT egy nap akár biológiai fegyverek kifejlesztéséhez is támpontokat ad.

És valóban: egy mindenki számára elérhető „virtuális PhD szakértő” rossz kezekben akár olyan tudást adhat, ami alkalmas károkozásra, például mérgező anyagok előállítására vagy hackertámadások kivitelezésére. A másik probléma, hogy a GPT-5 által generált emberi hang vagy szöveg a megtévesztés új dimenzióit nyithatja meg: a modellel élethű álhíreket, adathalász üzeneteket vagy hamis audiofelvételeket lehet készíteni, ezáltal pedig gyanútlan embereket manipulálni.

Noha a GPT-5 biztonsági mechanizmusai erősebbek, mint valaha, egyik AI-modell sem teljesen biztonságos. Továbbra is fennáll a veszélye, hogy a rosszindulatú felhasználók kijátsszák a védelmet, és ráveszik a modellt, hogy segítsen nekik tiltott dolgok végrehajtásában. A GPT-5 esetén különösen érdemes odafigyelni, hiszen a fent tárgyalt „biztonságos befejezés” módszer miatt a modell készségesebben ad valamennyi információt akár veszélyes témákban is.

Egy másik veszélyforrás a kulturális torzítások kérdése lehet. Bár a GPT-5 betanításánál sokkal több figyelmet fordítottak az adatok kiegyensúlyozására és a modell finomhangolására, nincs rá garancia, hogy ne lennének benne rejtett előítéletek. A vallási, etnikai, nemi vagy politikai érzékenységek terén egy ilyen erős modell apró hiba esetén is kárt okozhat, például azzal, ha sértő kijelentést tesz egy népcsoporttal kapcsolatban.

Végül a GPT-5 bevezetése új jogi és etikai kérdéseket is felvet, ami bizonyos szempontból veszélyforrásnak tekinthető a társadalomra. Ott van például a szerzői jogok védelme: mivel a modell hatalmas adatbázisból tanult, továbbra is előfordulhat, hogy szerzői joggal védett szövegeket vagy azok parafrázisát adja ki.

Az AI-val foglalkozó etika szakértők arra figyelmeztetnek, hogy a GPT-5 olyan gyors és nagy ugrás, hogy a társadalmi felügyelet, a törvényhozás és az oktatás nehezen tartja vele a lépést. Ez önmagában új típusú kockázat, hiszen egy újabb és még korszerűbb, szupererős eszköz került az emberiség kezébe, aminek a használatára még nem alakultak ki semmilyen normarendszer.