„Az emberiség erre agyban nincs felkészülve” – Tilesch György szerint a mesterséges intelligencia fejlődési sebessége szinte felfoghatatlan

Bár a mesterséges intelligencia 66 éves fogalom, az első modellek is nagyon régóta léteznek, sőt, használható mesterséges intelligenciák is már jó ideje szolgálnak minket, de igazán láthatóvá most vált, hol is tart ez a technológia. A ChatGPT, majd a GPT4, illetve a különböző képalkotó modellek hirtelen élményszerűvé tették a mesterséges intelligenciát.

De történt valami ennél is fontosabb. Tilesch György szerint az eddigi lineáris fejlődés a történelem során először valódi exponenciális sebességre váltott.

– Jött egy hír nemrég, hogy az olasz kormány fontolgatja a ChatGPT betiltását. Miért? Olyan veszélyes valóban?

– A ChatGPT az a rendszer, amiről sokan beszélnek, de igazából ez csak leegyszerűsítő megjelölése a témának. Az ugyanis még nagyon-nagyon sok gyermekbetegséggel rendelkező megoldás volt, és pár hónapra rá már ott volt a GPT4, ami klasszisokkal jobb, ráadásul ugyanattól a cégtől, az Open AI-tól jött. De az összes konkurense is dolgozik hasonló modelleken, pár már ezekből ki is jött.

Tehát a ChatGPT igazából csak bevitte a mainstreambe az információt, hogy van működő mesterséges intelligencia, ami kétségkívül hasznossá vált, de rengeteg még a megoldandó feladat. Az olasz kormány részéről felmerült betiltási tervekről az gondolom, hogy az még nem lezárt ügy. Az olaszoknak az adatvédelemmel foglalkozó ügynöksége hívta fel az Open AI figyelmét arra, hogy súlyos hiányosságok vannak. Ezek után az Open AI maga döntött arról, hogy ideiglenesen kiviszi az olasz piacról a ChatGPT-t.

Európában most készül egy szabályozási hullám, amelynek a kimunkálásában sok olasz is vesz részt, ez az EU AI Act, ami novemberben, vagy előbb meg fog jelenni. Szerintem annyi történik, hogy példát akarnak demonstrálni nemzetállami szinten is, hogy már a törvény, illetve az európai szintű jogszabály hatályba lépése előtt megpróbálják valahogy kikényszeríteni bizonyos érzékeny adatok védelmét, vagy legalábbis jelezni aggályos részterületeken a cégeknek, hogy eddig és ne tovább. Nem gondolom, hogy ez frontálisan szembe menne az AI terjedési hullámával. Az OpenAI is dolgozik azon, hogy bizonyítani tudja, megfelel az olasz kormány, illetve az adatvédelmi ügynökség elvárásainak. Szerintem a versenyszférában van egy nagyobb probléma, és ezt nem nagyon tudják a jelen pillanatban kiküszöbölni. Ha egy vállalati közegben, vagy kormányzati közegben használják a ChatGPT-t, tehát ahol érzékeny adatokkal dolgoznak, és esetleg arra kérik meg, hogy egy meetingnek a leiratát összegezze és küldje ki mindenkinek, vagy egy pénzügyi jelentést készítsen el vállalati adatok alapján, akkor azok az adatok bizony felmennek Redmondba, a Microsoft szerverére, meg az Open AI-hoz. Ezek az adatok onnantól kezdve részévé válnak annak a korpusznak, ami alapján a mesterséges intelligencia modell működik, ami azt jelenti, hogy

Ezért is vannak ezek a reakciók.

– És akkor még a latorállamok MI fejlesztéseiről nem is beszéltünk...

– Szabályozni csak azt tudjuk, ami kereskedelmi forgalomban van, elő lehet fizetni rá, meg lehet vásárolni stb. A latorállamok nem azt a stratégiát fogják folytatni, hogy megpróbálják meghekkelni a Big Tech által piacra dobott nagy generatív MI rendszereket, bár azért erre is lesznek próbálkozások szerintem. Ugyanis a kereskedelmi forgalomban elérhető nagy nyelvű modelleknél szakemberek ezrei dolgoznak azon, hogy minél bombabiztossabbá tegyék etikai, biztonsági kockázati szempontokból ezeket a modelleket.

Tehát kissé leegyszerűsítve: az Európai Unió meghatározhatja például azt, hogy milyen feltételekkel jöhet be egy kínai AI modell az európai piacra, és ezt kőkeményen be is kell tartani a kínaiaknak, azonban, ha nem akar nyilvánosan bejönni a piacra, hanem valahol a szürke vagy sötét zónában kíván tevékenykedni, az ellen nem sok fegyverünk van a jelen pillanatban.

– Tehát másolható, ellopható ez a technológia?

– Igen. Vannak olyan országok, melyek a nulláról építik újra ezeket, és vannak olyanok, amelyek az elérhető információk és technológiai specifikációk alapján megpróbálják megépíteni a klónjukat, de olyan is előfordulhat, hogy részleteiben el tudják lopni, tehát ezerféle módszer létezik erre.

És ők pont azzal védekeztek, hogy a lator államok sokkal könnyebben ellophatják, ha ismerik a részleteket. Ez a mai napig erősen megosztó, mert az Open AI, mint brand, ma már minden, csak nem open (azaz nyílt). Olyan szempontok feszülnek egymásnak, amelyek között nagyon nehéz igazságot tenni, mert mindenki valahol ködösít. De vannak például jótékony célú klónozási vagy közösségi megoldások is. Európában például van egy modell, aminek az a neve, hogy Bloom. Ez volt az első olyan klón, amit kifejezetten társadalmi, hasznossági szempontok vezettek. Ez tavaly november-december környékén jöhetett ki, a francia állam kölcsönadta az egyik szuperszámítógépét egy tudományos közösségnek, körülbelül ezer egyetem 2500 embere hozta össze az első európai közösségi modellt, amihez én nagyon nagy reményeket fűztem. Nincsen a közelében sem most annak, amit a GPT4 csinál, de mindenképp kijelölt egy utat.

Azt is kell nézni, hogy ki csinálja, és milyen szándékkal csinálja.

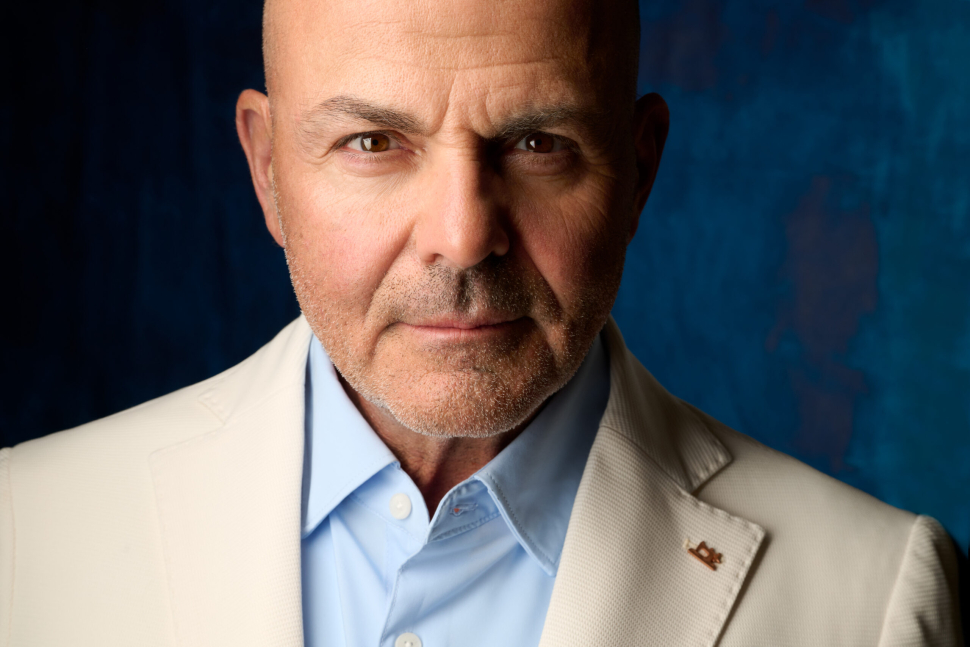

Tilesch György, magyar-amerikai mesterséges intelligencia (MI) szakértő, tanácsadó, cégvezető és író, aki az Egyesült Államokban él és dolgozik.

A washingtoni Fehér Ház MI-etikai munkacsoportjának tagja, a PHI Institute for Augmented Intelligence alapító elnöke és a Neumann Társaság MI-nagykövete. Omar Hatamleh-val közösen írt egy könyvet az MI okozta gazdasági, politikai és társadalmi változásokról Mesterség és Intelligencia címmel. Magyarországhoz is kötődik, többek között a Neumann János Számítógéptudományi Társaság megemlékezés-sorozatában és egy MI-képzési programban is részt vesz.

– Mekkora egy ilyen rendszer fizikailag? Elvihető egy bőröndben? Mi kell ahhoz, hogy ez működjön?

– Ezeknek a modelleknek a leginkább meghatározható faktora, ami alapján összehasonlíthatóak voltak, a paraméterszám. Tehát a bonyolultsága és a mélysége. Illetve a betanításhoz szükséges infrastrukturális és számítási kapacitás. Minél nagyobb modellt akarunk, és minél bonyolultabb és mélyebb modellt akarunk alkotni, annál nagyobb az igény mind adatoldalon, mind infrastrukturális oldalon, mind tehetségi és elővigyázatossági oldalon.

Volt egy sztori pár héttel ezelőtt, hogy az Open AI a Google-tól elhozott egy AI-gurut, akinek az első dolga volt azt mondani, hogy a Google, amely most ugye ideiglenesen hátrányba került, mert később jött a piacra, az már az Open AI adatain tanította be a saját modelljét, ami nagyon kínos volt, és jogilag is lesznek még ennek következményei. Magyarán nagyon-nagyon keveseknek van hozzáférése az adatmennyiséghez, ráadásul akiknek van, azokat is folyamatosan támadják, hogy egyáltalán volt-e joguk azokat az adatokat feltölteni a modelljeikbe. Tehát mondjuk milyen jogon használja fel a modell például a Wikipédia adatait, vagy a Redditet, ami alapján egyébként a legtöbb társalgás megtörténik.

Tehát van egy csomó dolog, ami szürke zónában van. A GPT3-as körülbelül 175 milliárd paraméterrel rendelkezett, a GPT 4 konkrét adatait nem tudjuk, mert senki nem mondta meg. De óvatos becslések szerint is a korábbinak körülbelül a 100-szorosa lehet. Ezek elképesztő számok. Hogy mást ne mondjak, 100 amerikai család egész éves energiafogyasztása az az energiaigény, ami egy ilyen modell betanításához kell.

– Tehát fogyaszt annyit, mint egy komoly gyár.

– Igen, és sokan tartanak is attól, hogy ha elindul ezeknek a modelleknek a proliferációja, magyarán mindenki megpróbálja a sajátját megcsinálni - akár egy éven belül is eljuthatunk oda, hogy mindenki saját AI modellt fejleszt -, akkor

Ez az érem egyik oldala. A másik oldala nyilvánvalóan az, hogy ezek a nagy cégek az AI-t már arra is használhatják, hogy a modellek betanítási energiaköltségét, a szervereik fogyasztását csökkentsék. A Google 25% körüli energiafogyasztás-csökkentést tudott elérni. Tehát nagyon érdekes és komplex ez a világ, mert egyik oldalon drámai a helyzet, viszont a másik oldalon ugyanazt a technológiát lehet jobbításra is használni. Nagyon nehéz fekete-fehéreket mondani, és azt hiszem, tévút is lenne.

– Háborús célokra, fegyverrendszerek irányítására is használható ez az eszköz?

– A nyelvi modellek két okból értek el áttörést. Az egyik az, hogy az embernek egy személyes élményt nyújtanak, tehát képesek társalogni. Ezt mondjuk egy számítógépes látási modell vagy egy komplex adatanalitikai rendszer nem tudja nyújtani. A nagy nyelvi modellek megjelenésével szinte észrevétlenül átléptünk abba a korba, amit úgy hívnak, hogy multimodalitás. Korábban azt mondtuk, hogy a szűk AI-nak a korszakában vagyunk, amikor egy-egy feladatra lehet betanítani, és azt végrehajtja, általában jobban, mint az ember. A multimodalitás azt jelenti, hogy horizontálisan nagyon sokféle feladatot tud elvégezni, amelyeknek csak egy része szigorúan nyelvi. Ezt úgy hívják angolul, hogy general purpose AI, vagyis általános felhasználású AI.

Tehát mielőtt még kereskedelmi forgalomba kerülne bármi, a hadászati felhasználása már évek óta megy. Ez a technológia sem kivétel ez alól. Én 2017-ben már dolgoztam Amerikában a Pentagonnal nagy mesterséges intelligencia projekteken, amiknek nem hadászati célja volt alapvetően, mert abban nem vettem volna részt, de a hadsereg karolt fel egy olyan mesterséges intelligenciát, ami a hadihajók karbantartásáról szólt, és 7 milliárd dollárt spórolt meg évente az amerikai haditengerészetnek. A hadászati felhasználások száma már jelenleg is végtelen. Ha megnézi azt, hogy autonóm drónok harcolnak már különböző isten háta mögötti régiókban a világban, az egy jelentős áttörés. Ezek az eszközök ugyanis nem távirányítottak, hanem

Azt szerintem kevesen tudják Magyarországon, hogy az ukrán hadsereg ellenállóképességének egy jelentős faktora az, hogy az amerikai Palantir nevű AI cég beállt mögéjük. Hallotta már ezt a nevet?

– Nem.

– Ez egy érdekes cég, ami tulajdonképpen azt csinálta, hogy egy adatanalitikai rendszert adott nekik, amiben már korábban volt egy csomó műholdas felvétel, és a harctéri egységek megkapták azt a lehetőséget, hogy bármikor fotókat és adatokat töltsenek fel a rendszerbe.

Tehát ez például óriási előny volt, amit ők egyébként nem is tagadnak. Mondok egy másik példát. Van egy Clearview AI nevezetű amerikai startup, amelyik Amerikában perek sorozatát kapta a nyakába az elmúlt években, mert semmi mást nem csinált, mint hogy a közösségi médiáról, meg a Google Fotókról, és hasonló alkalmazásokról szerezte be illegálisan több tízmillió, százmillió ember fotóját. És ezek alapján létrehozott egy olyan, bármikor lekérdezhető adatbázist, ami AI számítógépes látás alapján azonosítja az embert. Tehát ha én önről csinálok most egy fotót, feltöltöm, akkor megmondja nekem a Clearview AI, az Ön összes social media profilja és hasonló megjelenései alapján, hogy maga kicsoda. Ez kereskedelmi forgalomban elérhető megoldás, amit egyébként azt hiszem, 800 rendőrkapitányság használ Amerikában, így fél-legálisan, de bűnözők azonosítására.

– Erről eddig még csak kínai viszonylatban hallottunk, hogy így azonosítják az embereket, pontozzák is ráadásul.

– Az teljesen más, vagyis nem teljesen más, de Kínában ezt a párt csinálja, Amerikában meg egy startup. Ez nagy különbség. Egy startup, amelyik el tudta adni a termékét X darab amerikai rendőrőrsnek anélkül, hogy a szövetségi állam, vagy akár egy tagállam bele tudott volna szólni. De emiatt perek sokasága következett. Ekkor a Clearview AI, aminek nagyon komoly PR problémái voltak Amerikában, azt csinálta, hogy ingyen és bérmentve felajánlotta ezt a szoftverét az ukrán államnak és az ukrán hadseregnek, és az alapján nagyon jól tudják azonosítani például a saját halottaikat, és az orosz halottakat is. Tehát így tudják visszaigazolni, hogy kik voltak azok, akik meghaltak, vagy háborús bűncselekményeket követtek el

– Lehet, hogy használták ezt akkor is, amikor azonosították a bucsai tetteseket?

– Majdnem biztos.

– Nagyon gyorsulnak a dolgok, persze amióta létezik emberiség, azóta egyfolytában azt éljük meg, hogy gyorsul a fejlődés, és ez a gyorsulás exponenciális, ami egy darabig talán még követhető, aztán egyre kevésbé lesz követhető. Az a kérdés, hogy meddig tudjuk ezt ép ésszel követni?

– A nagy korszakváltást abban látom most, hogy szerintem eddig nem exponenciálisban voltunk. Tehát eddig, amikor ipari forradalmakról beszéltünk, azért mindig volt pár évünk vagy pár évtizedünk, hogy átálljunk egyik technológiáról a másikra. Szerintem az AI, és különösen a generatív AI hozta el igazából az exponencialitást, amiről az én szűkebb pátriámban, Szilícium-völgyben nagyon sok vátesz és sárkányfűárus már regélt évtizedek óta, de ez sokáig nem volt kézzelfogható az embereknek. Most szerintem abszolút exponenciálisban vagyunk. Hogy mást ne mondjak, én körülbelül nyolc éve foglalkozom mesterséges intelligenciával, és egészen tavalyig azt tudtam mondani, hogy még át tudjuk látni az ugrásokat, mert az éves ugrások félévesek lettek, a félévesek haviak, satöbbi. De ha most bármilyen szakmai szimpóziumon részt veszek, és megnézek egy chartot arról, hogy az elmúlt héten mi történt AI-ban, akkor 30 olyan dolgot látok minden héten, ami mérföldkőnek számít. Na és ez az, amit nem tudunk befogadni szerintem. Tehát a kérdésére az a válaszom, hogy

Ezért történt az is, hogy egyébként általam nagyon tisztelt, és sok esetben személyesen ismert AI tudósok és szakértők moratóriumot kezdtek el követelni, amiről gondolom ön is olvasott, mert pont ez volt a célja, hogy mindenki olvasson róla. Egy nyílt kiáltványt tettek közzé, amiben azt kérték, hogy fél évig most mindenki álljon le.

– Ez megoldaná a helyzetet?

– Ők egy klasszikus nyilvános tárgyalási technikát követtek. Tehát, ha túl sokat kérünk, és megkapjuk a 20 százalékát, már akkor is egész jól vagyunk. Nyilván abban nem bízhattak semmilyen szinten, hogy ez így át fog menni. Körülbelül három évvel ezelőtt volt egy olyan hullám Amerikában, amikor rájöttek arra, hogy az arcfelismerőkben, tehát a valós idejű biometrikus azonosító-rendszerekben nagyon sok a probléma. Emlékszem, hogy volt egy nyári két hét, amikor az ottani cégek, amelyek ilyen rendszerek fejlesztésével foglalkoztak, azt mondták, hogy leállunk vele, vagy azt mondták, hogy nem adjuk el hadászati és rendészeti célokra, ami pedig ennek az elsődleges felhasználása volt.

Ezt valószínűleg fiaskóként élte meg a technológiai szektor. Visszatérve erre a kiáltványra, én úgy gondolom, hogy a szándék nemes volt, és nagyon nagyra értékelem, hogy kitették az asztalra a problémát. Ez a következőképpen hangzik:

Tehát a kérdés az volt, hogy fél évig, amíg a megfelelő szabályozási környezet nem jön létre, addig álljunk le. A fél évet azért számolták, mert mostantól számított fél éven belül biztos, hogy az EU kijön egy szabályozással. Az USA is most rekordsebességre kapcsolt szabalyozásilag. Az elvárás maga az irreális volt, de az, hogy ez téma lett a társadalomban és a legfelsőbb körökben, az szerintem hasznos volt.

– Öt év múlva hogy fogunk élni? Nem adok 10-et, csak 5-öt, hátha ellátunk még odáig.

– Én 2-3-at szoktam maximum bevállalni, de azt is évekkel ezelőtt. Meg se merem jósolni őszintén, szóval pontosan emiatt, mert tavaly november óta elszabadultak a dolgok. Amit látok biztosan, hogy a világ jelenlegi fragmentáltsága, tömbösödése szerintem csak erősödni fog, tehát

Már látszik egy kínai modell, látszik egy európai modell, és valahogy körvonalazódik egy amerikai, ami egyébként egy kicsit homályosabb. Amerika most éppen gondolkodik, hogy mit kéne lépni, elég-e az, hogy a mi technológiai cégeinknél van az elsőbbség még jelen pillanatban, vagy európai mintára brutál erős szabályozást kell bevezetni. Tehát lesznek ilyen, hogyha úgy tetszik, AI alapú társadalmi operációs rendszerek, amelyek között szerintem nagyon kevés átjárás lesz. Ez a globalizmus egyfajta visszavetése lesz, hiszen eltérő és inkompatibilis modellek fognak létrejönni. Azon a válaszúton vagyunk, mint emberiség, hogy

Ennek a demokráciákban szerintem alapelvnek kellene lennie. Én alapvetően nem osztom azt a negatív jövőképet, amit sok AI-szakértő jósol, hogy legalább 10% az esélye annak, hogy az AI következtében az emberiség kipusztul, azt viszont gondolom, hogy amennyiben nyakló nélkül hagyunk benyomulni egy exponenciális erőt például a munka világába, vagy az információszerzés világába, abból jó dolog nem jöhet ki. Tehát az exponencialitás sebessége, és az, hogy kinek a kezében van az AI, egy robbanóelegy tud lenni. Felelős gondolkodásra van szükség, és a társadalom részéről arra, hogy kikényszerítse a döntéshozóiból, hogy olyan AI-t kapjon, amilyet megérdemel.