Balogh Petya: A kínai DeepSeek semennyire nem veszélyes, sőt, egy demokratikusabb irányba viszi az AI-fejlesztést

Komoly pánikot váltott ki Amerikában, hogy egy kínai cég olyan mesterséges intelligenciával állt elő, amelyik töredékáron készült, és mégis hasonló teljesítményt nyújt, mint a ChatGPT. A DeepSeek mindössze 5,6 millió dollárba került. A hírre az amerikai tőzsde a történelem egyik legnagyobb részvényzuhanásával reagált. A mesterséges intelligenciákhoz drága chipeket gyártó NVidia egyetlen nap alatt 600 milliárd dollárt veszített az értékéből. Ez 17%-os esés, igaz, az első pánik után másnap 8%-ot erősödtek a cég részvényei.

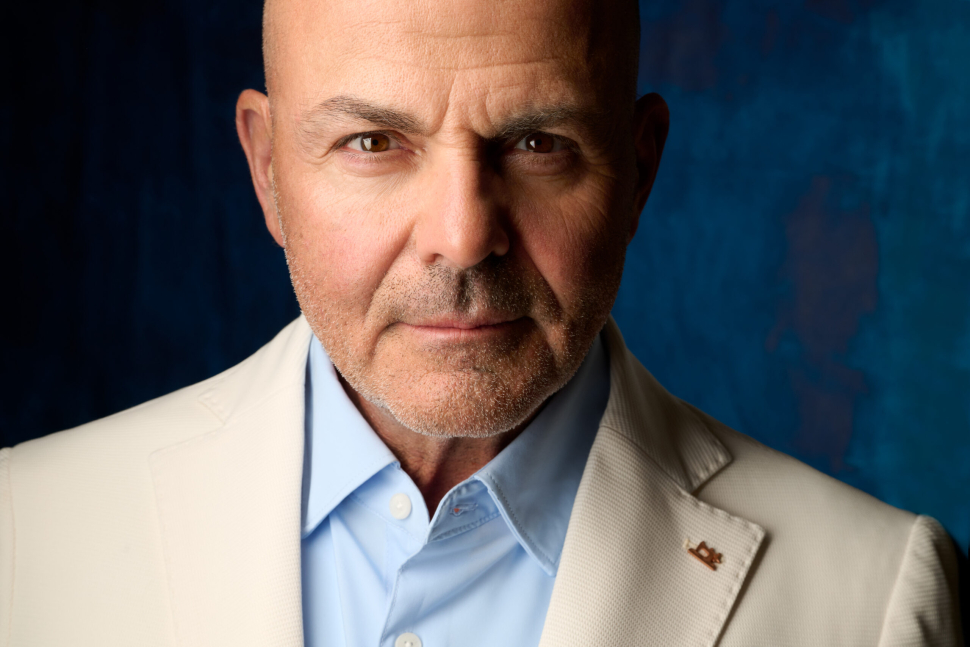

Donald Trump úgy reagált, végsősoron jó dolog történt, mert hosszabb távon olcsóbban lehet majd fejleszteni. Hogyan lehet, hogy ilyen olcsón ki tudott jönni a DeepSeek, és ez az esemény milyen hatással lesz a mesterséges intelligencia fejlesztésére? A kérdéseinkre Balogh Petya válaszolt, aki az STRT Holding Nyrt igazgatósági elnöke, és befektetéseik mellett csapatával tavaly több ezer cégvezetőnek tartott oktatást az AI fejlődéséről és várható üzleti hatásairól. Kiderült, őt kifejezetten feldobták az új fejlemények.

– Örülünk, és miért örülünk?

– Azért, mert az egyik nagy dilemmája a technológiának az utóbbi évtizedekben, hogy több olyan technológia volt, ami nagyon nyitottnak, nagyon szabadnak és demokratizálónak indult, és végül egy-egy monopólium rátelepedett. Maga a webes böngészés és információszerzés is szabadnak indult, hiszen bárki tud weboldalt csinálni, de aztán kiderült, ahhoz, hogy bárkinek a weboldalát megtaláljuk, csak egy darab játékos lett a Google, akin keresztül ezt hatékonyan és jól lehetett megoldani.

Ugyanígy a social médiában a Meta, azaz a Facebook anyacége, az Instagram és más platformok révén szintén monopóliumot alakított ki, és most arra törekszik, hogy a TikTokot is megszerezze, ezzel tovább erősítve pozícióját. Tehát egy szabadnak, nyitottnak indult technológiából végül monopólium lett. A mesterséges intelligencia kapcsán ez azért veszélyes, akárcsak a Google kapcsán, hogy aki a tudáshoz való hozzáférést vezérli, annak nemcsak brutális gazdasági, hanem hihetetlen politikai befolyásoló ereje is lesz. Nem véletlen, hogy amikor Trump először nyert, akkor azt egyértelműen egy, a Facebookot ügyesen használó csapatnak, a Cambridge Analyticának köszönhette jelentős mértékben, mert a Facebookot, mint manipulatív eszközt a politikai célokra fegyverként bevetve tudtak a szavazókra hatni.

És akkor jön egy kis kínai játékos, aki pedig megmutatja, hogy több nagyságrenddel olcsóbban közel olyan színvonalat tud előállítani. És nem elég, hogy megcsinálja ezt, és árban versenyezne vele, hanem a teljes fejlesztését, az összes programkódot, a teljes adatbázist, a létrejövő mesterséges intelligenciát mindenestől bedobja a közösbe.

– Ez neki miért jó?

– Érdekes, hogy nem ők kezdték ezt a játékot, hanem nyílt forráskódú fejlesztésben is sokan kísérletezgettek, hogy tudnak-e valami hasonlót csinálni, mint a ChatGPT, de a legnagyobb játékos az utóbbi években ebben a Meta lett, a Facebook anyacége. A cég még nem tudja, hogyan fog üzleti hasznot húzni, de azt tudja, hogy nem szeretné, ha a három nagy monopóliumból valaki más nyerje meg a versenyt. Ezért egy Llama nevű modellt tett elérhetővé, amely szintén ingyenesen hozzáférhető.

Most a kínaiak rájöttek arra, hogy mindabból a kutatási eredményből, amit az emberiség az utóbbi években a témában felhalmozott, hogyan lehet nagyon olcsón, nagyon könnyen, közel olyan szintű mesterséges intelligenciát előállítani, mint egy évvel ezelőtt a csúcstechnológia volt. És ez nekik kevesebb, mint 6 millió dollárba került, és egy kis csapattal csinálták meg, ráadásul egy kis kutatócsapattal. Innentől ez továbbfejleszthető, újra tréningezhető.

És ami még izgalmasabb, hogy amennyiben valaki erre építve egy új dolgot akar fejleszteni, akkor már ingyen elérhető ez a lépcső, és innen már csak a következő lépésre kell költeni. Azaz hirtelen a nyílt forráskódú, a mindenki által hozzáférhető, mindenki által ingyen használható technológia, ha nem is leelőzte, de majdnem utolérte a csúcstechnológiát.

– Ez nagyon szépen hangzik, hogy innentől kezdve bárki a saját képére és hasonlatosságára szabva újabb és újabb AI-okat tud létrehozni. Na, de ezt mégiscsak egy nem éppen baráti hatalom fejlesztette ki. Biztos, hogy nem veszélytelen ránk nézve, hogy ez az AI Kínából jön?

– Szerintem semennyire nem veszélyes. Nyilván a DeepSeek-ként elérhető modellben vannak olyan témák, amik a kínai központi narratívát tartalmazzák, és ha csak egy olcsó konkurenciája lenne a ChatGPT-nek, ha nem adtak volna ki semmit nyílt forráskódra, akkor ez egy olcsóbb, csak éppen egy másik ország aktuális narratíváját közvetítő modell lenne, amiben lehetne egyfajta társadalmi, kulturális, politikai veszély. De igazából mindegyik nagy nyelvi modell tud eszköz lenni arra, hogy valakinek a narratíváját közvetítse.

Ennek adott egy újabb lökést most a DeepSeek is, de ez egyben azt is jelenti, hogy nagyon hamar fog valaki csinálni majd egy ugyanilyen tudású, szintén ingyenes, akár ingyen hozzáférhető, de a kínai helyett például egy európai narratívát közvetítő modellt. És igazából ez benne a jó. A társadalom érdeke nem abban van, hogy az amerikai vagy a kínai narratívát hordozó modell győzzön, hanem hogy nagyon sokféle modell legyen, és legyen köztük verseny.

– Nagyon sok esetben tetten értük azt, hogy a kínaiak elég kreatívan értelmezik a licencjogot. Biztosak vagyunk benne, hogy ez a DeepSeek teljesen originális fejlesztés, és nem részben ipari kémkedés eredménye?

– A mesterséges intelligencia területén az az izgalmas, hogy nagyon felgyorsultak az események, de a technológia nagyja bárki által elérhető tudományos publikációkban zajlik. A szédítő gyorsaságról tavaly nyáron volt egy személyes élményem: kijött egy új kutatási publikáció, ami újfajta algoritmust javasolt arra, hogy hogyan lehetne hatékonyabban képeket generálni. Majd pár nappal később megjelent a forráskód, ami ezt megvalósította, szintén ingyen hozzáférhetően, mert valaki ezt elolvasta és implementálta, ezután megint csak pár nappal később már le lehetett tölteni egy olyan ingyenes, közösség által fejlesztett szoftvert, ami ezt tudta, és pár héttel később pedig a fizetős szoftverekbe is beépült ez az új megoldás. Talán az OpenAI az egyetlen, aki a nevével ellentétben szinte semmit nem publikál, vagy nagyon keveset csak. A 60-as években az Intel, akkori nevén Fairchild Semiconductor marketingvezetője megfigyelte, hogy kétévente duplázódik az ugyanannyi dollárért eladott tranzisztoroknak a száma. Kétévente tudnak mindig duplázni és újra duplázni. Akkor 100 tranzisztor volt nagyjából egy mikrochipben. Gordon Moore volt ez az ember, és róla nevezték el Moore törvényét. Ha ez a jóslata akkor igaz, akkor most, mivel 60 év alatt 30-szor duplázott a technológia, a 100 darab tranzisztorból mára körülbelül 100 milliárdnak kellene lennie.

Az AI viszont, ahogy én is kutattam, nem ezen a pályán fejlődik, hanem ennél meredekebb a gyorsulás üteme. Összegyűjtöttem az ezzel kapcsolatos kutatásokat és eredményeket, amiből az rajzolódott ki, hogy a főbb hajtóerejei a mesterséges intelligencia fejlődésének oda mutatnak, hogy jelenleg nagyjából évi 26-szoros az a tempó, ahogy fejlődik.

És ez alapján én azt számolgattam, hogy ha valaki a ChatGPT négyesnek az egy-másfél évvel, majdnem két évvel ezelőtti színvonalát most valaki a kutatási költség huszadáért, huszonötödéért, tehát pontosan olyasmi összegért tudja megvalósítani, mint amennyibe a DeepSeek került, az nagyjából ezen a trendvonalon van rajta. Azaz van-e egy brutális, felfoghatatlan, emberi aggyal beláthatatlan fejlődési tempó, és az, hogy a DeepSeek 6 millió dollárból megcsinálta azt a modellt, ami körülbelül az egy évvel ezelőtti ChatGPT-vel pariban van nagyjából, az pont ennek a brutális fejlődésnek a visszaigazolása.

– De ha innen nézzük, hogy az új kínai AI rajta van ezen a vonalon, akkor valójában nem volt akkora meglepetés, hiszen csak egy korábbi modellel jött ki, ami pontosan ennek megfelelően olcsóbb. Akkor viszont nem értem ezt a nagy tőzsdei pánikot.

– Az ad okot pánikra, az a nagy kérdés merült fel, hogy amit készítenek 5 milliárd dollárból, annak egy éven belül az értéke a huszada lesz. Ez a dilemmája annak a típusú kutatásnak, amit az OpenAI is végez, meg a Google, vagy az Anthropic is.

Azonban, ha évről évre drasztikusan csökken a belépési küszöb, hogy valaki ugyanezzel foglalkozzon, akkor nem lesz monopólium, és az nem tudja kirabolni az emberiséget, akkor nem tud az OpenAI-ba, vagy a Microsoftba, vagy a Google-be, vagy az Anthropicba fektetett sok milliárd dollár sokszorosan megtérülni. És ez okozta az ijedtséget, hogy ezek a típusú befektetések, amit az alapmodell fejlesztésére fordítanak, valószínűleg sohasem fognak megtérülni. Viszont voltak olyan cégek, amiknek nem esett a részvényárfolyama. Ezek azok voltak, amelyek nem ezzel a típusú alapkutatással foglalkoznak, hanem csak használják a mesterséges intelligenciát.

És ez azt jelenti, hogy valószínűleg a mesterséges intelligencia körül a nagy megtérülés nem az alapmodellek fejlesztésében lesz, hanem a mesterséges intelligencia modellek ipari, vagy kereskedelmi hasznosításában, azaz a megoldások készítésében.

– Én szőrösszívű kapitalistaként valóban kivonnám a pénzemet az alapkutatásból, viszont ennek az lenne a következménye, hogy lelassul vagy leáll maga a fejlesztés, nem lesznek újabb modellek.

– Igen, és nem. Biztos, hogy emiatt lesz tőkekivonás ezekből a nagyon nagy alapkutató cégekből. A másik oldalról viszont van egy Hugging Face nevű gyűjtőoldal, ahol mesterséges intelligencia modelleket lehet publikálni ingyen. Az a különlegessége ennek az oldalnak, hogy ma már több mint egymillió különböző mesterséges intelligencia modell érhető el ott ingyen, publikusan a közösségbe bedobva, és több mint 3 millió fejlesztő van ebben a közösségben, akik mesterséges intelligencia fejlesztéssel foglalkoznak valamilyen szinten. Tehát nem fog ettől leállni a folyamatos fejlődés, mert már nem néhány szakember, szűk kis csoportokban, elszigetelten viszi előre ezt a tudományágat, hanem nagyon széles fejlesztőbázisa lett, rengeteg ebbe beletanuló szakértővel, akik együtt hozzák az innovációkat és áttöréseket.

Például az Nvidia részvényei azért estek, mert rájöttek a befektetők is, hogy ha nem fog tízmilliárdokat költeni a Google évente AI-hardverek beszerzésére, akkor az a pénz nem fog beáramlani az Nvidiához, így hosszú távon nem tudja azt a profitabilitást, bevételszintet az Nvidia biztosítani. Mert a másik nagy csavar a sztoriban az, hogy a kínaiak azért tudták 6 millió dollárból megoldani a saját fejlesztésüket, mert az amerikaiak blokkolták, hogy a legkorszerűbb chiptechnológiához hozzáférhessenek Kínában, ezért kénytelenek voltak a számukra elérhető, kevésbé fejlett technológiát használva dolgozni.

– Hogy állunk az AI karbonlábnyomával? Bizonyos hírek szerint a legnagyobb környezetterhelést jelenleg ez az iparág okozza.

– Ez nem igaz. A ChatGPT elkér tőlünk 4-5 dollárt 1 millió szótagnyi gondolkodásért. Azért egymillió szótagnyi gondolkodás az sok, tehát azt be lehet látni, hogy annyit olvasni vagy írni, vagy végiggondolni, az nagyon sok gondolkodás, és az pár dollárba kerül. Ez a bizonyos 26-szoros fejlődési tempó, ebben az is benne van, hogy ugyanazt a szintű gépi gondolkodást, amit egy évvel ezelőtt egy dollárnyi energiából tudtunk megcsinálni, azt mostanra kb. a tizedéből. Tehát van egy drasztikus csökkenése az egy egységnyi gondolkodásra eső energiaköltségnek. Az tény, hogy nagyon sok cég rengeteg üzleti alkalmazásban és nagyon sok gondolkodást használ, és ezek nagyon központosítottan, néhány adatközpontban jelentkeznek, és nem mindenkinek otthon a saját számítógépén.

Számokra fordítva: az OpenAI néhány százmillió dollárt költ áramra évente, így alig egy ezrelékét használja az Egyesült Államok összes energiafelhasználásának, valószínűleg a teljes AI iparág is kevesebb, mint egy százalékát összesen, miközben a bitcoin globális működése a teljes amerikai fogyasztáshoz képest 2,5-4 százalékot. Az AI rengeteg közvetlen hasznot hajt, többszázmillió embernek segítve naponta, míg a másikkal csak spekulálni lehet. Abba is gondoljunk bele, hogy ha egy emberrel gondolkodtatnánk egymillió szótagnyit, akkor több hétig kellene őt etetni, itatni, energiával ellátni, kiszolgálni az igényeit, feldolgozott élelmiszert az asztalára tenni. Könnyen belátható, hogy csak ez nagyságrendekkel több, mint pár dollár. Ilyen szempontból az egységnyi elvégzett munkára vetített lábnyom messze tört része minden másnak, ráadásul több gondolkodást tud az emberiség végezni, mint korábban. Ráadásul a modellek robbanásszerű fejlődésével, ami akkor is észvesztően gyors marad, ha vissza is vesznek kissé a tempóból, hamarosan eljutunk oda, hogy

Ilyen körei voltak már a technológiának, amikor hirtelen mindent szerverekre raktunk, aztán meg kiderült, hogy sokkal praktikusabb egyes programokat helyben futtatni, mert már helyben is tudjuk, hiszen olyan okosak a készülékeink. Tehát nem gondolom, hogy ennek a technológiának hosszú távon brutális kell, hogy legyen az energialábnyoma, pontosan a fejlődési tempója teszi lehetővé azt, hogy ez ne így legyen.