Tényleg úgy néz ki, mint Elon Musk – így dőlnek be sokan az AI-val készült, hamis videóknak

Az online világ mindig is tele volt veszélyekkel, a digitális bűnözés pedig egyidős a világhálóval. Bár mostanra nevetségesen átlátszónak tűnik a kamu nigériai herceg e-mailje, amiben sokszoros kamatra kért kölcsön random emberektől, az adott korszak technológiai lehetőségeihez képest igenis hatásos csalás volt.

A gyanútlan emberek kifosztási lehetőségeit aztán tovább bővítették a közösségi média platformok. Az ipari méretűvé dagadt dezinformálás miatt ma már szinte romantikusnak tűnik az amerikai katonatiszt története, aki a személyes találkozással kecsegtetve vallott szerelmet magányos nők százezreinek, csak fizessék ki végre a repülőjegy árát. Napjainkban ezeknél sokkal kifinomultabb módszerekkel kell szembenézni:

A csalás pedig automatizálható: már nem kellenek a fiktív karakterek mögé emberek, akik csevegve csalják lépre az áldozatokat. Elég egy meggyőző kamu videó, amire a benne szereplő ismert személy miatt az egész világon tömegek figyelnek fel, és egy online ügyintéző felület, a pénz utalására.

Az AI-alapú deepfake technológia lehetővé tette, hogy manipulált videók ezrei terjedjenek el. Sok gyanútlan befektető rajta is vesztett olyan hamis befektetési lehetőségeken, amilyeneket a világ leggazdagabb embereként ismert Elon Musk – pontosabban annak AI-val generált digitális mása ajánlott.

Érdekes iróniája ez a sorsnak, hiszen a Tesla és a SpaceX mellett a Twitter-utód X-et is birtokló milliárdos nemrég maga is megosztott egy AI-val generált videót, amelyben az általa támogatott Donald Trump ellenfele, Kamala Harris szájába adtak vállalhatatlan mondatokat.

Deepfake Elon Musk az egész nyugdíját elvitte

A New York Times különösen szemléletesnek tartotta, ezért a riportjában ki is emelte (a sok közül) a 82 éves Steve Beauchamp történetét.

A nyugdíjas mindössze a családját akarta támogatni egy jó befektetéssel, amikor „kapóra jött neki” Elon Musk forradalmi befektetési lehetőséget és gyors hozamokat ígérő videója. Az idős férfi elhitte, hogy az igazi dollármilliárdosról van szó, így számlát nyitott a videót megosztó kamu cégnél, először csak 248 dollárral (kb. 90 ezer forinttal). Néhány hét alatt aztán több tranzakciót is végrehajtott, míg végül csaknem 690.000 dollárt (közel 248 millió forintot) fektetett be – az egész nyugdíjszámlájának kiürítése árán. Végül a pénz persze eltűnt, nyoma sem maradt.

– nyilatkozta a lapnak Beauchamp, egyértelművé téve, hogy a videón látott személy az ő számára a megtévesztésig hasonlított Elon Muskra.

Az áldozat az ehhez hasonló tartalmakat magából egyenesen okádó Facebookon látta a videót, és nem esett le neki, hogy amit néz, az valójában deepfake, vagyis AI-val manipulált hamisítvány. A kiberbűnözők egyébként egy valódi Musk-interjút használtak fel, átszerkesztették annak hangját egy AI-eszközzel, és még a szájmozgásokat is tökéletesen szinkronizálták az új forgatókönyvvel.

Az efféle hamisítványok olyan tökéletesek, hogy egy átlagos néző számára szinte észrevehetetlenek. Hogy ez mennyire igaz, azt az alábbi videó remekül szemlélteti.

Ahogy az osztott kijelző jobb oldalán látható kamu Musk (pontosabban a demonstrációs célú videót készítő etikus alkotó) mondja, „ez egy deepfake példa arra, hogy mire képes egy jó számítógép és szerkesztőprogram”. Hozzáteszi: az elkészítése egy erős grafikus processzor használatával 72 órát vett igénybe, de „további számítási kapacitással még jobb eredményt lehetne elérni”, miközben az emberek 90 százalékban már ezt sem tudják megkülönböztetni az eredetitől.

Vadul terjed a deepfake-csalás

Az utóbbi hónapokban több ezer olyan AI-vezérelt deepfake videó került fel az internetre, amelyek hamis Elon Muskokat használtak potenciális befektetők megtévesztésére – meglehetősen sikeresen. A New York Times elemzésekre hivatkozva úgy becsüli, hogy az ilyen generált videók évente több milliárd dollárt húznak ki az emberek zsebéből. Mindeközben ezeket a tartalmakat fillérekből elő lehet állítani, és ha megfelelően erős hardver áll rendelkezésre, akár percek alatt elkészülhetnek.

A videókat jellemzően a hamisítványok kiszűrésében továbbra is dilettánsnak tűnő közösségi médiában, például a Facebookon terjesztik, ráadásul gyakran fizetett hirdetésként, ami azt jelenti, hogy

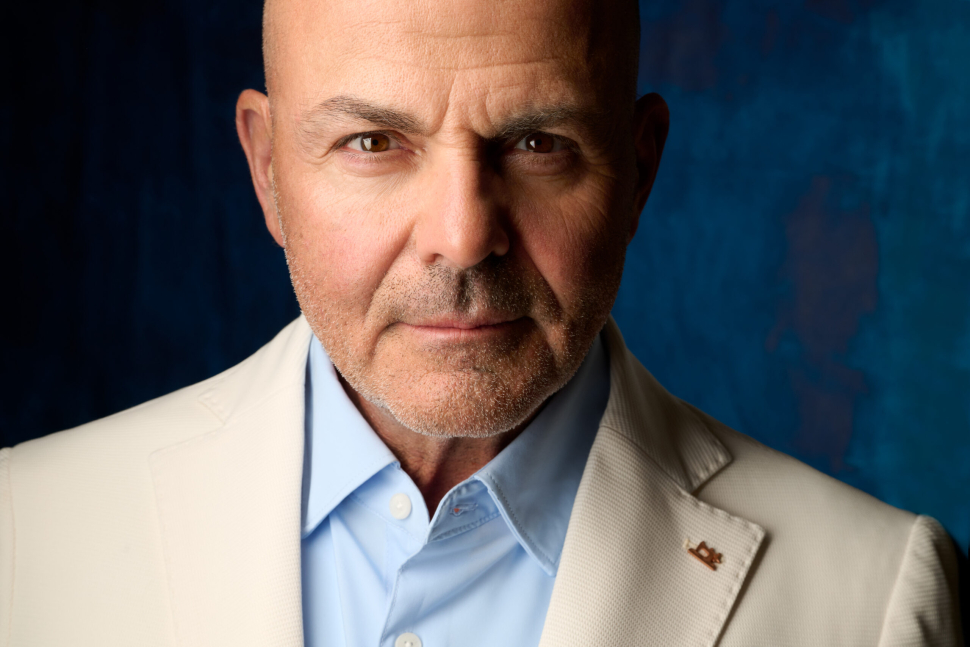

Francesco Cavalli, a deepfake-eket figyelő és elemző Sensity társalapítója szerint az Elon Musk arcát és hangját felhasználó videó „valószínűleg a legnagyobb deepfake által vezérelt csalás”, amit valaha látott a világ. A technológia révén ezek a videók gyakran szinte hátborzongatóan élethűek, mint az, aminek a fent írt nyugdíjas is bedőlt, hiszen gyakorlatilag hibátlanul hozta Musk jellegzetes akcentusát és beszédstílusát. A világ leggazdagabb emberei közé tartozó milliárdos amúgy a leggyakrabban használt mintája a deepfake csalásoknak, különösen a kriptovalutákra összpontosító kampányokban.

Hogyan készül a deepfake?

Mivel a generatív AI fejlődése gyors és megállíthatatlan, muszáj felkészülni rá, hogy gyakorlatilag bárkivel bármit ki lehet mondatni, ha a cél emberek meggyőzése – vagy a pénzük átadásáról, vagy a politikai, vallási, társadalmi értékrendjük megváltoztatásáról. Óriási árnyoldala ez egy olyan technológiának, ami a civilizáció fejlődését pozitív irányba is lökdöshetné – ahelyett, hogy megfelelő fékek és kontrollok nélkül mindenki játékszerévé teszik, ahogy anno a közösségi médiát (és látjuk, mi lett belőle).

A deepfake-ek gyártása meglepően egyszerű és olcsó folyamat, következésképp tömegek számára hozzáférhető. Az AI hangmásoló eszközeivel bármilyen híresség hangját klónozni lehet. Ezzel addig nincs is gond, amíg az veszélytelen szórakozási céllal történik. Itt éppen Orbán Viktor énekli meg Gyurcsány Ferenc választási győzelmét:

Az AI-val manipulált hang birtokában szájmozgásokat manipulálni képes videógeneráló alkalmazásra van szükség, és ha a szoftver kellően kifinomult, a számítógép grafikus teljesítménye pedig kellően magas, akkor megtévesztően hitelesnek tetsző tartalmak születhetnek.

Még élethűbb hamis tartalmak, még kiszolgáltatottabb felhasználók

A generatív AI-val készült tartalmakkal elsősorban technológiai háttérismeretekkel kevésbé rendelkező, és a hírekkel kapcsolatban nem elég kritikus embereket lehet megtéveszteni. Jól példázza ezt a fent írt Kamala Harris videó, amiben az amerikai elnökjelölt az őt támogató Joe Bident szenilisnek, magát pedig az ország vezetésére alkalmatlannak nevezi, aki csak azért lett demokrata elnökjelölt, mert színesbőrű nőként diverzitási aduásznak számít.

A híreket hiteles forrásból követők számára egyértelmű, hogy Harris – nyilvánosan legalábbis – biztosan nem mondana ilyesmit, tehát kamu videóról van szó.

– írja az NBC News, és jócskán akadhattak köztük olyanok, akiknek a politikai véleményét befolyásolta a tartalom, főleg úgy, hogy egy sokak szemében hiteles közszereplő tette közzé, ráadásul olyan, aki politikailag szembe helyezi magát Harris-szel.

Amikor nem dezinformálás, hanem közvetlen lopás a cél, hasonló dolog történik: arra ugyan hiteles személyt nem lehet felkérni, hogy maga ossza meg az arca és hangja felhasználásával készült kamu tartalmat, ám a hitelesség látszatát elő lehet idézni – például úgy, hogy a befektetési tanácsot egy valódinak tűnő, online pénzügyi konferencia álcája alá rejtik. Az a tény, hogy a videón látszólag valós személy oszt meg igaznak tűnő állításokat, és mindez valóságosnak tűnő, nyilvános esemény keretei közé helyeződik, sokaknak már elég, hogy előkotorják a bankkártyát és fizessenek.

Beauchamp esetében viszont ennél is tovább mentek a csalók: nem elég, hogy az idős férfi elhitte azt, amit látott és fizetett, még újabb befektetési lehetőségekkel is kecsegtették – olyan hamis visszaigazolásokat küldve, amelyek a tőkéje növekedését mutatták. Akkor azonban, amikor ki akarta venni a pénzét, egy sor adminisztratív díjat és jutalékot kellett fizetnie, míg végül a teljes nyugdíjmegtakarítása odaveszett.

Fel kellene venni a kesztyűt a terjesztők ellen

Ahogy sok állam különbséget tesz a drogbirtoklás és a drogterjesztés között, érdemes lenne azokat fülön csípni, akik révén a kamu tartalmak eljutnak az emberekhez.

Ezzel próbálkozik mostanában egy ausztrál milliárdos, aki szintén deepfake videók áldozata lett – számolt be a The Guardian.

Andrew Forrest beperelte a Facebookot működtető Metát, amiért annak hirdetési rendszere „ártatlan felhasználókat vesz rá rossz befektetésekre”. A Meta erre azt nyilatkozta, hogy folyamatosan fejlesztik az AI-alapú automatikus észlelési rendszereiket, hogy kiszűrjék a csalókat, de szerintük véget nem érő harcról van szó:

Ettől függetlenül valóban vannak próbálkozások: a YouTube például szintén igyekszik harcolni a manipulált videók és a csalások ellen. A NY Times szerint csak 2024 első negyedévében több mint 15,7 millió csatornát és 8,2 millió videót töröltek a közösségi irányelvek megsértése miatt. A YouTube emellett kötelezővé tette, hogy a tartalomkészítők jelöljék, ha AI-alapú technológiát használnak videóikban – kérdés, hogy ezt megteszik-e, és ha nem, azt a jövőben hogyan szándékoznak kiszűrni.

Van vége ennek az egésznek?

Lou Steinberg, a CTM Insights alapítója szerint „a szervezett bűnözés rájött, hogy pénzt tud csinálni az AI-ból, így egyre több és több kísérlet lesz”. Az AI-generált videók egyre jobbak, és a jövőben valószínűleg még hitelesebbé válnak. Az egyéni felhasználók számára a legfontosabb tanulság az, hogy mindig kritikusan, természetes kételkedéssel álljanak hozzá az online látott tartalmakhoz, különösen, ha pénzről vagy befektetésekről van szó! A valószínűtlenül magas hozamok például mindig gyanúsak, és ha egy ajánlat túl szép ahhoz, hogy igaz legyen, akkor valószínűleg nem is az.

Ami pedig a nem túl távoli jövő választási kampányait illeti, elég valószínű, hogy egymást érik majd a Kamala Harriséhez hasonló videók, amelyekkel az egyik politikai oldal igyekszik ellehetetleníteni a másikat – például az opponens vezéregyéniség hitelének rombolásával.

Egy szoros választási versenyben néhány száz szavazat eldöntheti választókörzetek sorsát, így a parlament összetételét is. Ami biztosan a demokrácia hanyatlásához vezet – csak az a kérdés, mikor? Nagy szükség lenne a deepfake tartalmak terjesztésének mihamarabbi szankcionálására, illetve arra, hogy a társadalom tudatosabb hírfogyasztóvá váljon. Mert ha minden úgy megy tovább, ahogy most, akkor óriási baj lesz.