Tartósan és életveszélyesen forró lehet a nyár az Alföldön és a nagyvárosokban, ha nem csökkentjük a kibocsátásokat

Mintegy 90%-os valószínűséggel állíthatjuk, hogy az emberi tevékenység miatt nő a tartós hőhullámos napok száma Magyarországon. Míg a hetvenes-nyolcvanas években országos átlagban nem volt ilyen nap, ez mára évi 2 napra emelkedett. Ez a szám csak országos átlagban tűnik alacsonynak: míg az északi és a hegyvidéki tájainkon nagyon ritkák a hőhullámok, addig az Alföldön a legextrémebb évben, 2012-ben 18 tartós hőhullámos nap volt. A jövő még lesújtóbb: a pesszimista forgatókönyv szerint, ha a jelenlegi módon folytatjuk a kibocsátásokat, úgy a mainál 12-szer több tartós hőhullámos napra számíthatunk a század végéig országosan. A déli országrész, Szeged környéke és az Alföld a legkitettebb, ahol 30 nap feletti éves értékeket várunk. Az évi maximumhőmérsékletek is mindenhol statisztikailag szignifikánsan emelkednek országszerte, azonban itt csak kb. 60%-os valószínűséggel jelenthetjük ki, hogy az emberi kibocsátások miatt történik mindez. Ez azonban nem csökkenti annak a kockázatát, hogy a pesszimista forgatókönyvet követve az Alföldön minden évben számíthatunk 40 °C-os maximumokra a század utolsó két évtizedében, különösen szélsőségesen forró években pedig 45 °C feletti értékek sem kizártak az ország legmelegebb részein, amit rajtunk kívül az infrastruktúra is meg fog szenvedni. Kizárólag egy mérsékelt kibocsátásokkal számoló jövőkép szerint van esélyünk annak megfékezésére, hogy a század közepétől ne szabaduljon el az emberi szervezetre akár életveszélyes hőhullámos napok száma, és az elindult exponenciálisan növekvő trendet lassítani tudjuk. Szabó Péter és Pongrácz Rita elemzése a Másfélfokon.

Jelen tanulmányban azt vizsgáljuk, hogy a tartós hőhullámok hogyan alakulnak hazánkban, vagyis amikor a napi átlaghőmérséklet legalább 3 napig 27 °C feletti. Emellett a nyári extrém értékeket, azaz az évi maximumhőmérsékleteket (a napi maximumhőmérséklet éves maximumát) is elemezzük. Megadjuk, hogy mi várható a jövőben a mérsékelt vagy fokozódó éghajlatváltozás és antropogén hatások esetén, és hogy a változásokért az emberi tevékenység okolható-e. Az elemzést a tartós hőhullámos napokkal kezdjük.

A hetvenes-nyolcvanas években nem volt, ma már szinte országosan lehet hőhullám /h2>

Tekintsük először az elmúlt 50 év megfigyeléseit (forrás: Országos Meteorológiai Szolgálat)! Idén épp most éljük át az első tartós hőhullámos napokat, amelyből tavaly a nyár folyamán országos átlagban 4 ilyen nap volt.

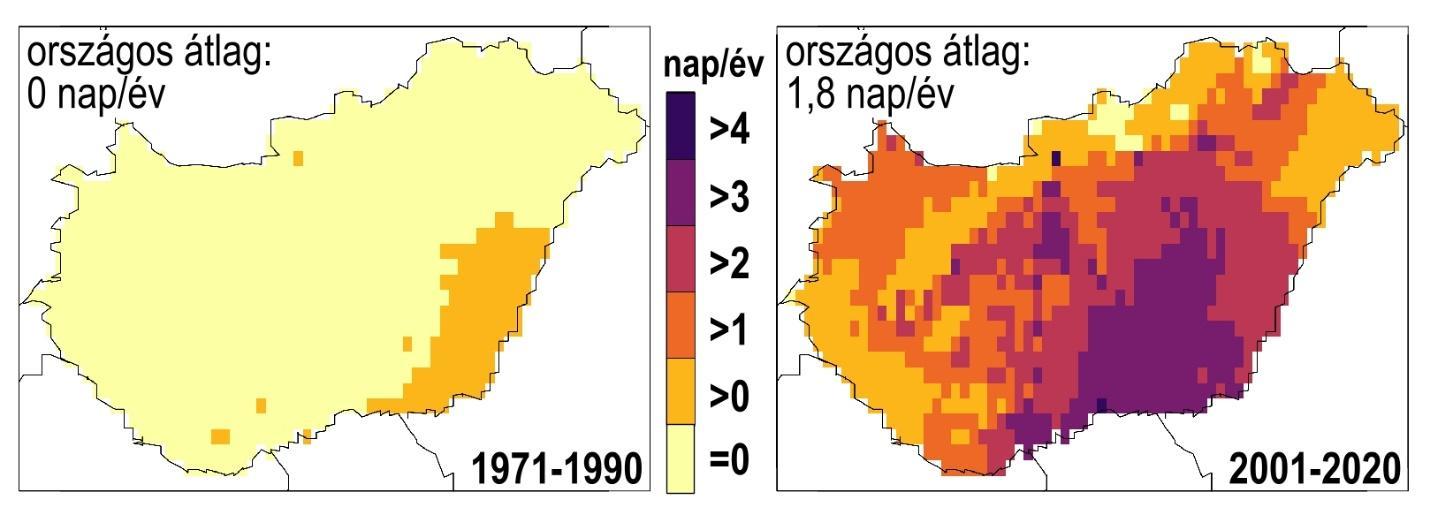

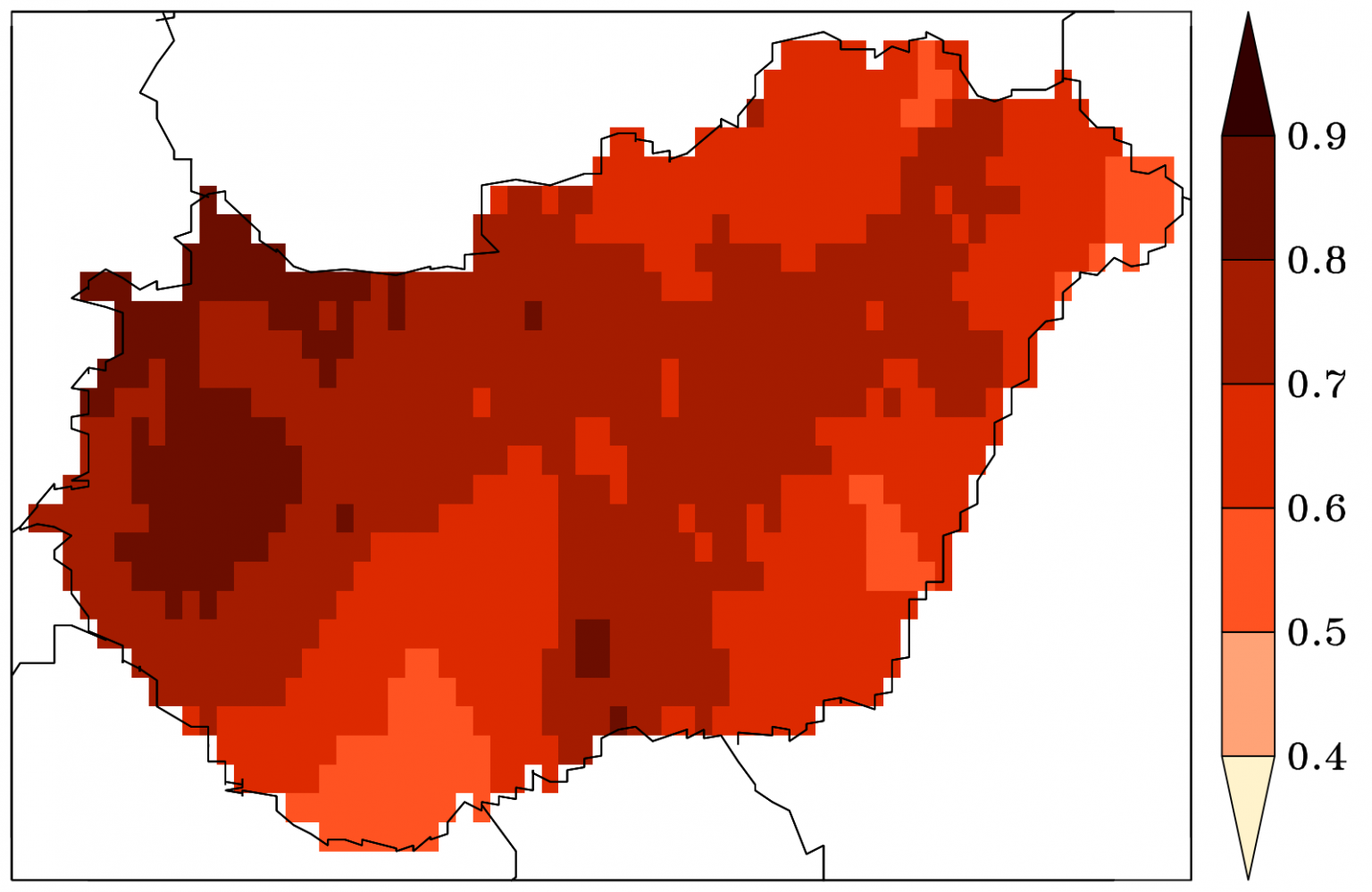

1. ábra: A tartós hőhullámos napok átlagos évi száma 1971-1990 és 2001-2020 között az Országos Meteorológiai Szolgálat mérései szerint. A szerzők ábrája.

1. ábra: A tartós hőhullámos napok átlagos évi száma 1971-1990 és 2001-2020 között az Országos Meteorológiai Szolgálat mérései szerint. A szerzők ábrája.2001-től vizsgálva ez jelentősen megváltozott, hiszen országos átlagban már évi két napra számíthatunk, az Alföld déli részén ennek duplájára is. A húszéves átlag azt jelenti, hogy ugyan nem minden évben várhatunk ennyi napot (pl. 2018-ban, 2019-ben vagy 2020-ban gyakorlatilag nem volt ilyen nap), de előfordulhatnak kevésbé elviselhető, szélsőségesebb évek is (pl. 2012-ben és 2015-ben országos átlagban 8, illetve 7 ilyen naptól szenvedtünk). Az országos átlag önmagában kevésbé tűnhet fenyegetőnek, de mivel az északi és a hegyvidéki tájainkon nagyon ritkák a hőhullámok, mindez azt jelenti, hogy

Ezt pedig már nem könnyű elviselni. Különösen az idősebbek és a kisgyerekek szervezete veszélyeztetett a nyári hőségek idején.

Mi okozzuk, és egész nyáron szenvedni fogunk jövőben, ha nem mérsékeljük a kibocsátásokat

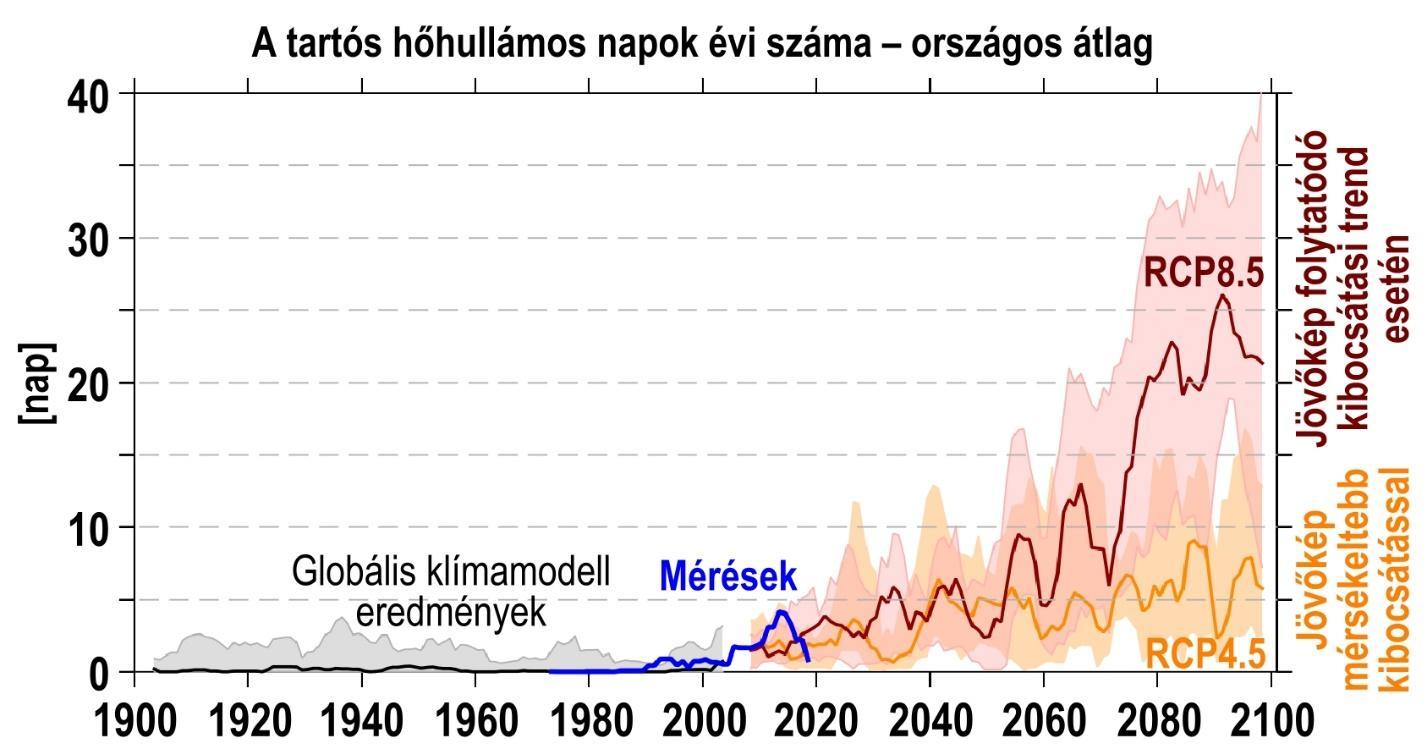

Ha elemzésünket kiterjesztjük a 20. század elejéig a rendelkezésre álló klímaszimulációk felhasználásával, az eredmények azt jelzik, hogy voltak ugyan olyan évek is, amikor előfordultak hőhullámos időszakok, de a manapság jellemzőhöz képest jóval ritkábban – olyannyira, hogy egyes évtizedekben a tartós hőhullámok szinte ismeretlenek voltak (2. ábra, szürke sáv).

Ahhoz, hogy az utóbbi három évtizedben megjelent, exponenciálisan növekvő trendről eldöntsük, hogy az emberiség felelős-e érte, az elmúlt szűk 50 évre vonatkozó, kétféle éghajlati szimulációt kell tekintenünk. Az egyik esetben a modellek csak természetes kényszereket vettek figyelembe, míg a másikban a valóságot, azaz az emberi tevékenység miatt növekvő üvegházgáz-koncentrációkat is. A szimulációk alapján a megfigyelésekkel megegyező trendet 9-ből 8 modell esetében csak akkor kapjuk meg, ha az emberi tevékenységet is figyelembe vesszük.

Ha a jövőbeli modelleredményeket tekintjük, a pesszimista jövőkép szerint várható helyzet rendkívül lesújtó. Az antropogén hatások további fokozódása miatt (2. ábra, piros sáv)

Ez az országos átlag azt jelenti, hogy sajnos lehetnek olyan évek is, amikor a nyár több mint 5-6 hetében szenvedni fogunk a hőségtől, ugyanakkor biztosan nem lesznek majd olyan évek, amikor egyáltalán nem fordul majd elő tartós hőhullámos nap.

A mérsékeltebb antropogén-kibocsátással számoló modellszimulációk alapján a növekedés annyira megszelídíthető, hogy a jelenlegihez képest átlagosan “csupán” 3-szorosra nőjön az előfordulási gyakoriság (2. ábra, narancs sáv).

2. ábra: A tartós hőhullámos napok Magyarországon az 1971-2020 időszak mérései (kék), valamint az 1900-2005 időszakban historikus kényszerekkel futtatott modellek (szürke), illetve a 2006-2100 időszakban az optimistább RCP4.5 (narancs) és a pesszimista RCP8.5 (piros) forgatókönyvet követő jövőbeli szimulációk alapján. Az eredményeken ötéves simítást alkalmaztunk, a színes sávok a legszélsőségesebb szimulációkat már nem tartalmazzák, a vastagított vonalak pedig a szimulációk mediánját jelölik. A szerzők ábrája.

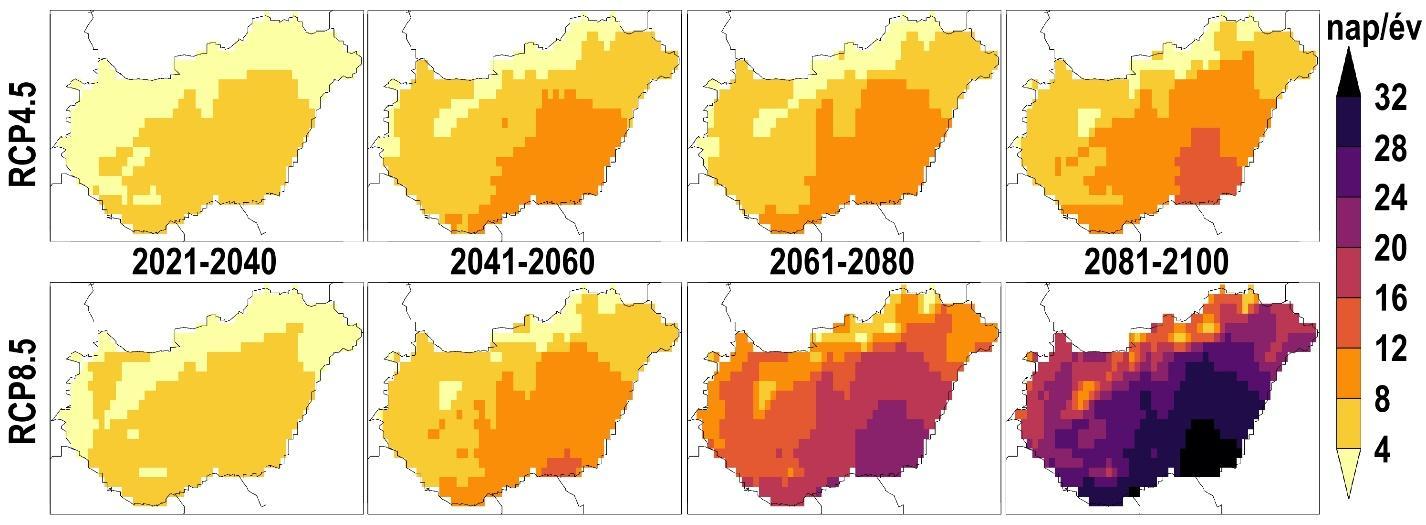

2. ábra: A tartós hőhullámos napok Magyarországon az 1971-2020 időszak mérései (kék), valamint az 1900-2005 időszakban historikus kényszerekkel futtatott modellek (szürke), illetve a 2006-2100 időszakban az optimistább RCP4.5 (narancs) és a pesszimista RCP8.5 (piros) forgatókönyvet követő jövőbeli szimulációk alapján. Az eredményeken ötéves simítást alkalmaztunk, a színes sávok a legszélsőségesebb szimulációkat már nem tartalmazzák, a vastagított vonalak pedig a szimulációk mediánját jelölik. A szerzők ábrája.Részletesebben a 3. ábra mutatja húszéves időszakokra lebontva, hogy a következő 80 évben az országon belül hol várható a legtöbb tartós hőhullámos nap. A legsötétebb színeket szinte mindig délkeleten, Szeged térségében találjuk. Itt az optimista és pesszimista forgatókönyv közötti különbség 2060-tól válik jelentőssé:

3. ábra: A tartós hőhullámos napok várható átlagos évi száma 2021-2040-ben, 2041-2060-ban, 2061-2080-ban és 2081-2100-ban az optimistább RCP4.5 (fent) és a pesszimista RCP8.5 (lent) forgatókönyvet figyelembe vevő modellszimulációk átlaga alapján. A szerzők ábrája.

3. ábra: A tartós hőhullámos napok várható átlagos évi száma 2021-2040-ben, 2041-2060-ban, 2061-2080-ban és 2081-2100-ban az optimistább RCP4.5 (fent) és a pesszimista RCP8.5 (lent) forgatókönyvet figyelembe vevő modellszimulációk átlaga alapján. A szerzők ábrája.Továbbá azt is láthatjuk, hogy a fosszilis energiahordozók folytatódó túlsúlyára alapuló jövőképet követve – a jelenlegi helyzettől jelentősen eltérően – szinte alig lesz olyan része az országnak, ahol egyáltalán ne fordulnának majd elő hőhullámok.

Nemcsak hosszabbak lesznek a hőhullámok, de még melegebbek is

A hőhullámok gyakorisága mellett egészségügyi szempontból további fontos tényező, hogy azok milyen intenzitásúak. Ehhez az évi maximumhőmérsékleteket elemezzük. Az elmúlt öt évtized mérései alapján az országban mindenhol statisztikailag szignifikánsan növekvő trendről beszélhetünk (4. ábra).

A jól érzékelhető növekedés nem egyenletes, és például a 2018-2020 időszak relatíve enyhébb volt: az országos évi maximumok 34-35 °C körüliek voltak, de az évek közötti ingadozások ellenére az utóbbi 20 év mindegyikében magasabb volt az országos átlagos maximumhőmérséklet, mint 40-50 éve. Az elmúlt 50 év legmelegebb napján, 2007-ben pedig az országos átlag 39,2 °C volt (sőt, hazánk területének ötödén 40 °C-ot is mértek).

4. ábra: Az évi maximumhőmérséklet évtizedes trendje [°C/évtized] az 1971-2020 időszakban az Országos Meteorológiai Szolgálat mérései alapján. A trend mindenhol statisztikailag szignifikáns. A szerzők ábrája.

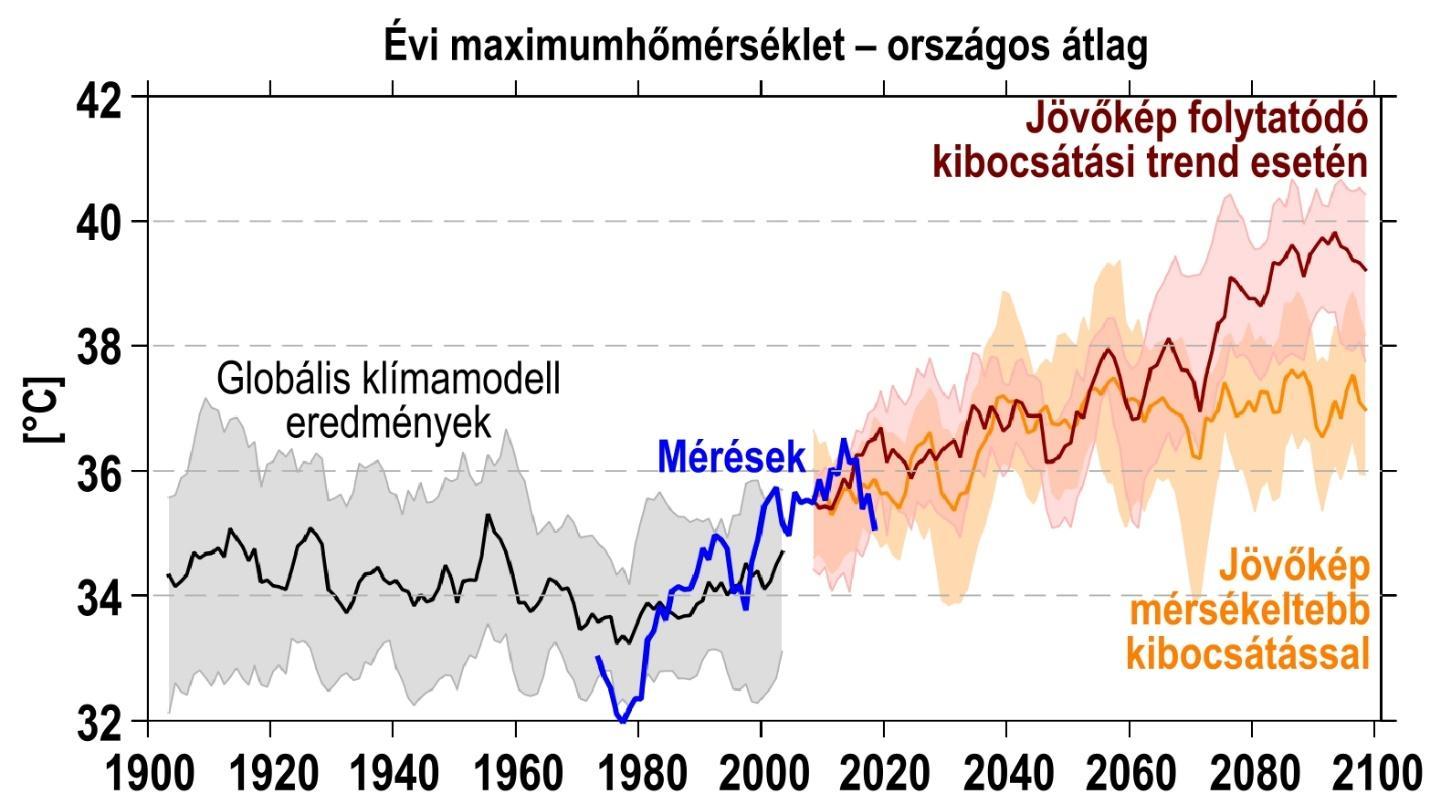

4. ábra: Az évi maximumhőmérséklet évtizedes trendje [°C/évtized] az 1971-2020 időszakban az Országos Meteorológiai Szolgálat mérései alapján. A trend mindenhol statisztikailag szignifikáns. A szerzők ábrája.Ha klímaszimulációkkal ezen elemzésünket is kiterjesztjük a 20. század elejéig, láthatjuk, hogy a század legnagyobb részén a belső változékonyság dominált (5. ábra, szürke sáv). Az utóbbi évtizedekben mért nem egyenletes, de növekvő trend vizsgálatakor is a csak természetes kényszereket figyelembe vevő és az emberi tevékenység okozta többlet üvegházgáz-növekedést is tekintő szimulációk alapján nyilatkozhatunk. 8-ból 5 modell esetén csak akkor kapunk a mérésekhez hasonló trendet, ha az emberi tevékenységet is figyelembe vesszük. Tehát

A jövőt vizsgálva megállapíthatjuk, hogy gyakorlatilag a jelenlegi trend folytatására kell felkészülnünk a pesszimista jövőkép szerint, és a század végén minden egyes évben a közelmúltban (2007-ben) még a legextrémebbnek számító 39 °C fölötti országos átlagokra számíthatunk. Ezzel szemben a mérsékeltebb kibocsátásokkal az éves maximumok 37 °C körüli tetőzésével kevésbé forrón tarthatnánk nyaraink legmelegebb napjait is (5. ábra, narancs és piros sáv).

5. ábra: Az évi maximumhőmérséklet Magyarországon az 1971-2020 időszak mérései (kék), valamint az 1900-2005 időszakban historikus kényszerekkel futtatott modellek (szürke), illetve a 2006-2100 időszakban az optimistább RCP4.5 (narancs) és a pesszimista RCP8.5 (piros) forgatókönyvet követő jövőbeli szimulációk alapján. Az eredményeken ötéves simítást alkalmaztunk, a színes sávok a legszélsőségesebb szimulációkat már nem tartalmazzák, a vastagított vonalak pedig a szimulációk mediánját jelölik. A szerzők ábrája.

5. ábra: Az évi maximumhőmérséklet Magyarországon az 1971-2020 időszak mérései (kék), valamint az 1900-2005 időszakban historikus kényszerekkel futtatott modellek (szürke), illetve a 2006-2100 időszakban az optimistább RCP4.5 (narancs) és a pesszimista RCP8.5 (piros) forgatókönyvet követő jövőbeli szimulációk alapján. Az eredményeken ötéves simítást alkalmaztunk, a színes sávok a legszélsőségesebb szimulációkat már nem tartalmazzák, a vastagított vonalak pedig a szimulációk mediánját jelölik. A szerzők ábrája.Az Alföld van a legnagyobb veszélyben, szélsőségesen meleg években akár 45 °C körüli hőmérséklet is lehet majd

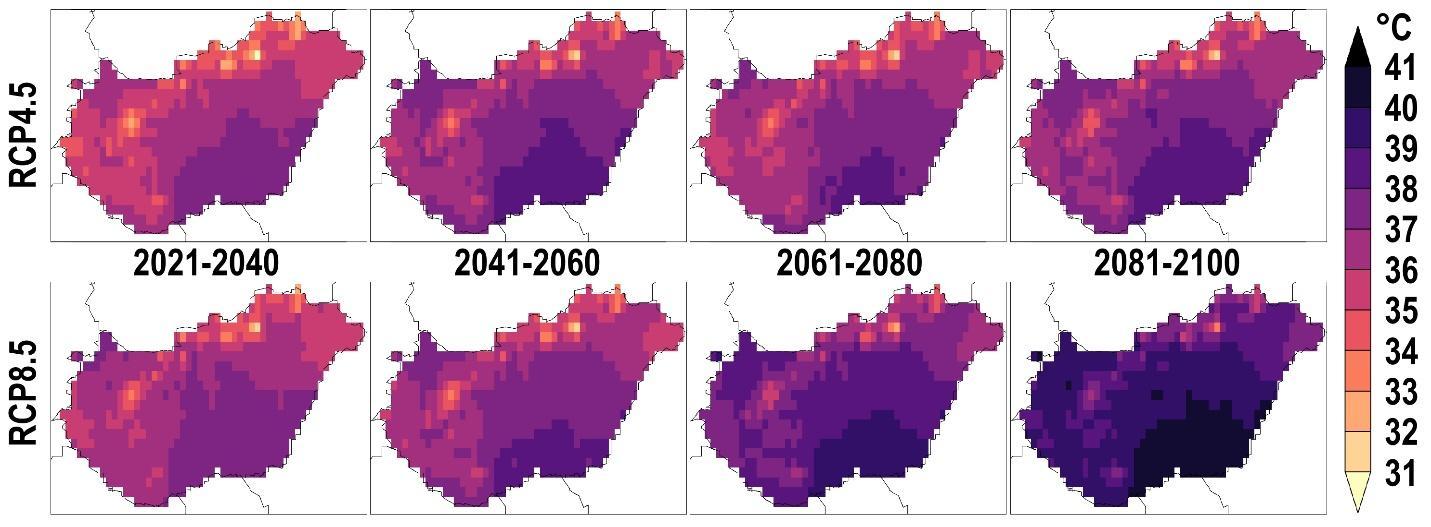

A térbeli szerkezetet kialakító okok – tehát a trópusi területekhez való relatíve közelebbi elhelyezkedés és a kontinentális hatás – változatlanok, így a 6. ábra szerint az ország déli, délkeleti felén várhatjuk továbbra is az évi legmelegebb nappali hőmérsékleteket. Az antropogén hatás jövőbeli alakulása persze a növekedés mértékében eltér: míg a pesszimista kibocsátást követve az Alföldön minden évben 40 °C-os maximumokra számíthatunk a század utolsó két évtizedében, addig az optimistább jövőkép szerint inkább “csak” 38 °C-ra.

A két forgatókönyv közötti különbség ugyan kisebb, mint a tartós hőhullámoknál, de ez nem jelenti azt, hogy ez a 2-2,5 °C-os különbség ne volna jelentős az emberi szervezetre gyakorolt hatás szempontjából (hiszen például a többlethalálozás a lineárisnál nagyobb arányban nő a hőtöbblettel).

6. ábra: Az évi maximumhőmérséklet várható sokéves átlaga 2021-2040-ben, 2041-2060-ban, 2061-2080-ban és 2081-2100-ban az optimistább RCP4.5 (fent) és a pesszimista RCP8.5 (lent) forgatókönyvet figyelembe vevő modellszimulációk átlaga alapján. A szerzők ábrája.

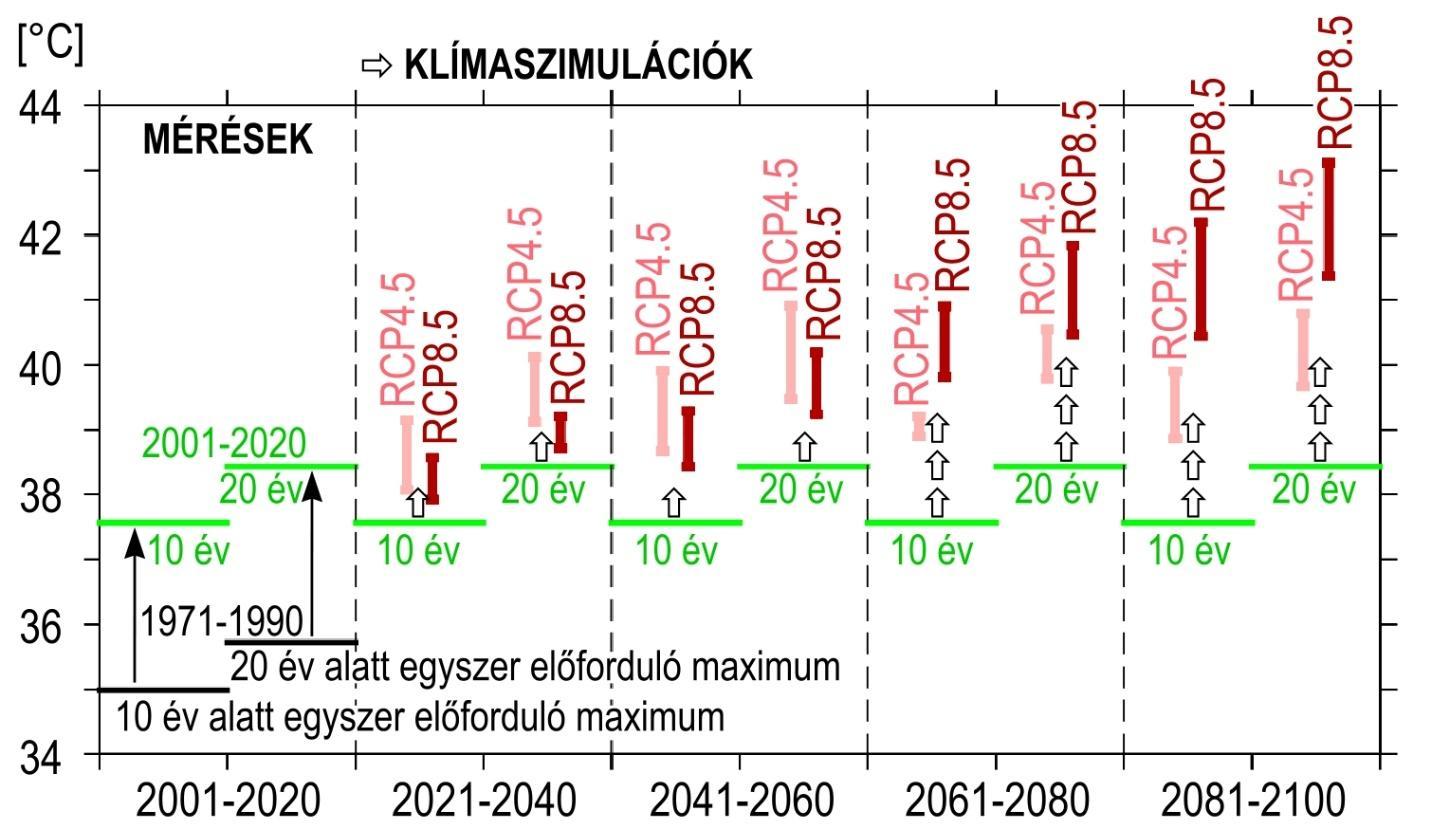

6. ábra: Az évi maximumhőmérséklet várható sokéves átlaga 2021-2040-ben, 2041-2060-ban, 2061-2080-ban és 2081-2100-ban az optimistább RCP4.5 (fent) és a pesszimista RCP8.5 (lent) forgatókönyvet figyelembe vevő modellszimulációk átlaga alapján. A szerzők ábrája.Ha nem csupán az évi átlagos maximumokra vagyunk kíváncsiak, hanem a mérnöki tervezés szempontjából is lényeges, rendkívül extrém, 10, illetve 20 évente átlagosan egyszer előforduló értékeket szeretnénk tudni, akkor sajnos nem állhatunk meg a 40 °C-nál. A 7. ábra ugyan országos átlagokat jelenít meg, mégis jól látszik, hogy míg 1971-1990-ben a megfigyelések szerint kicsivel 36 °C alatt voltak a 20 évente átlagosan egyszer előforduló maximumok, addig ez az érték a 21. század kezdetétől már teljesen átlagos lett, és a maximum inkább 39 °C közeli volt (lásd 2007-et, amikor a legmelegebb napon ennyi volt az országos maximumhőmérséklet).

Az eltolódás a modelleredmények bizonytalansága mellett a jövőben is folytatódik: a század végén a zöldebb jövőkép szerint 20 év alatt átlagosan egyszer számíthatunk 40-41 °C-okra, ugyanakkor a pesszimista szcenáriót követve az ijesztően magas 43 °C-os országos átlag lesz a 20 évente egyszer előforduló jellemző érték.

Az adaptációs felkészülés során az extrém hőstresszre érzékeny infrastruktúrák tervezésénél mindenképpen figyelembe kell venni tehát, hogy akár 45 °C-os értékek is előfordulhatnak.

7. ábra: Az extrém, azaz a 10, illetve 20 évente átlagosan egyszer előforduló maximumhőmérsékletek az 1971-1990 és 2001-2020 időszak mérései szerint [balra], továbbá a 2021-2040, 2041-2060, 2061-2080 és 2081-2100 időszakra az optimistább RCP4.5 és a pesszimista RCP8.5 forgatókönyvet figyelembe vevő klímaszimulációk alapján várható értékek tartománya [jobbra]. Az értékek az országos átlagra vonatkoznak, a tartományok a legszélsőségesebb szimulációkat már nem tartalmazzák. A szerzők ábrája.

7. ábra: Az extrém, azaz a 10, illetve 20 évente átlagosan egyszer előforduló maximumhőmérsékletek az 1971-1990 és 2001-2020 időszak mérései szerint [balra], továbbá a 2021-2040, 2041-2060, 2061-2080 és 2081-2100 időszakra az optimistább RCP4.5 és a pesszimista RCP8.5 forgatókönyvet figyelembe vevő klímaszimulációk alapján várható értékek tartománya [jobbra]. Az értékek az országos átlagra vonatkoznak, a tartományok a legszélsőségesebb szimulációkat már nem tartalmazzák. A szerzők ábrája.Mérséklés nélkül nem csupán forró, hanem életveszélyes is lehet a nyár a jövőben

Összefoglalva tehát: (1) A tartós hőhullámok az utóbbi két évtizedben egyre gyakrabban jelentkeztek, melyért egyértelműen az emberiség okolható. Nemcsak a hőség gyakorisága, hanem az évi maximumhőmérsékletek is jelentősen nőttek. (2) Ha a jövőben tovább folytatjuk a fosszilis energiahordozók intenzív használatát, és fokozzuk a globális felmelegedést, akkor a mai hőhullámok sokszorosa várható a 21. század végén – az Alföldön évi átlagban akár 30 nap felett. Ugyanitt pedig az évi maximumok várhatóan minden évben elérik majd a 40 °C-ot.

Mitigáció nélkül a pesszimista forgatókönyv szerint éves átlagban három-négyszer annyi hőhullámos naptól szenvedhetünk, mintha a zöldebb jövőt követnénk, és mivel nem lineáris a kapcsolat a hőhullámos napok és a halálozások között, ez várhatóan sokkal jelentősebb többlethalálozással jár majd. Ez különösen az Alföldet és a nagyvárosokat érintheti majd.

Az alkalmazkodási lehetőségek egyikeként szokás említeni a belterek hűtését; ennek azonban jelentős energiaigénye van, amit fosszilis energiahordozókkal biztosítva tovább erősítjük a globális felmelegedést, és egy öngerjesztő folyamatot táplálunk. Sokkal inkább megéri a kibocsátásokat csökkentenünk és áttérni egy zöldebb forgatókönyvre. Már csak azért is, hiszen a többi évszak melegedésével ellentétben a gyakoribb nyári hőségek már közvetlen, akár életveszélyes hatással vannak az emberi szervezetre.

Jelen tanulmány elkészítésében a szerzőkön kívül még részt vett: Bartholy Judit és Mráz Anna. Köszönet illeti a globális modellszimulációk elkészítéséért a WCRP CMIP 6. fázisában résztvevő intézményeket, a regionális modelleredményekért az Euro-CORDEX konzorcium modellező intézeteinek tagjait, a hazai megfigyelésekért pedig az Országos Meteorológiai Szolgálatot.

Te mit csinálnál másképp? - Csatlakozz a klímaváltozás hatásairól, a műanyagmentességről és a zero waste-ről szóló facebook-csoportunkhoz, és oszd meg a véleményedet, tapasztalataidat!