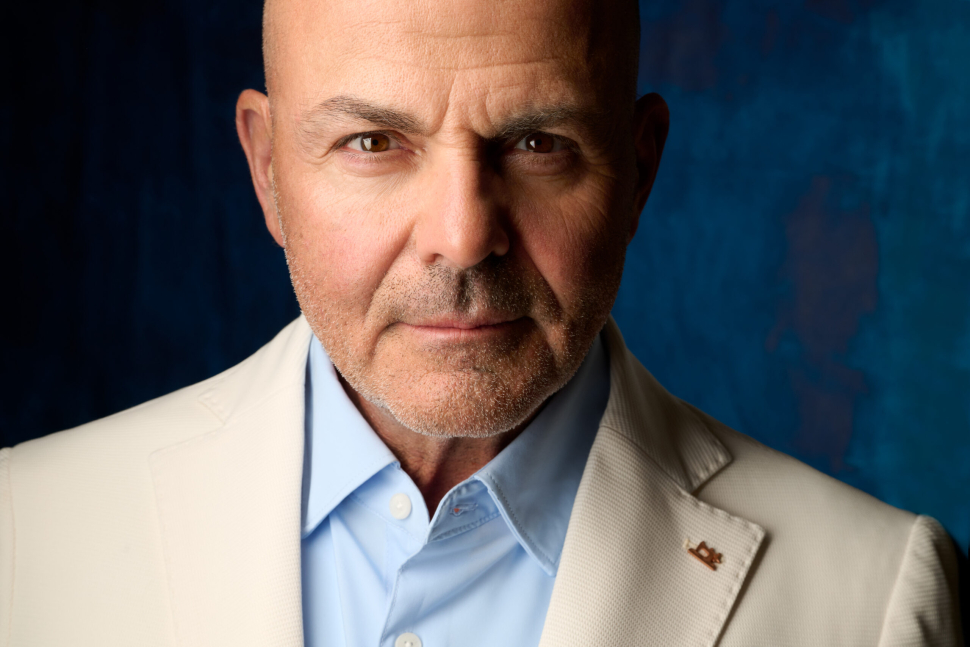

Pohly Ferenc: A robot kérdezőbiztos teljesen objektív, és egy csomó ember szívesebben és őszintébben beszél vele

Az idén nyáron alapított Minerva Intézet egy mesterséges intelligencia-alapú robotasszisztenssel végzi felméréseit. Július közepén például azt vizsgálták, milyen közhangulat, milyen témák foglalkoztatják az embereket, és hogy áll a Tisza és a Fidesz versenye.

Pohly Ferencet, a Minerva Intézet Nonprofit Kft. ügyvezetőjét arról faggattuk, hogy milyenek az első tapasztalataik az AI-asszisztenssel végzett telefonos közvélemény-kutatások kapcsán, és mennyire vált be a válaszadóknak, hogy nem élő ember van a vonal túloldalán? Arra is kíváncsiak voltunk, hogy ez a megoldás mennyiben jobb vagy hatékonyabb, mint a hagyományos, kérdezőbiztosokkal bonyolított kutatások, illetve milyen előnyöket rejt a technológia, ha az eredmények elkészítésére és elemzésére kerül sor.

- Miért döntöttetek az AI asszisztens használata mellett, milyen előnyt vártatok tőle, és mit kaptatok?

- Egyrészt azért döntöttünk mellette, mert mi, a Minerva Intézet alapítói nagyon régóta foglalkozunk ezzel a technológiával, tehát szöveggenerálással, szövegfelismeréssel és ezeknek mindenféle kommunikációs alkalmazásával. Hogy csak egy dolgot mondjak: ennek a Minerva robotnak a közeli rokona a MÁV-nál szolgálatot teljesítő Elvira nevű hangasszisztens. Ez a technológia a kezünkben volt, és úgy gondoltuk, hogy közvélemény-kutatási célra is rendkívül jó lehet. Ami pedig az előnyöket illeti: adja magát az automatizációtól várható előny, hiszen nem emberek végzik a kérdezést, hanem egy gép, ami nem fárad el, 0-24-ben tud telefonálni. Meg egyébként – és ez már egy olyan előny, ami nem feltétlenül magától értetődő – teljesen objektív.

Vagyis valamennyire megmondják, hogy mit kell gondolni. Nem feltétlenül arra gondolok, hogy tudatosan befolyásolják a résztvevőt, hanem ha az visszakérdez, hogy „jaj, melyik is az a párt, most nem jut eszembe”, akkor megmondják, hogy melyik párt, és ezzel a kérdés nem tölti be a funkcióját, hiszen önmagától kellett volna megneveznie egy pártot. Ilyen értelemben a robot kérdezőbiztos teljesen objektív. Mindenkit pontosan ugyanazzal a lendülettel és ugyanazzal az intencióval kérdez – nincs befolyásolás semmilyen irányba. Ebből adódik egy másik dolog is, ami szintén nagy előny.

Egyszóval könnyebben nyílnak meg és ezt el is mondják. A hívás végén az asszisztens közli, „ön most egy mesterséges intelligencia alapú robottal beszélgetett”, és megkérdezi, hogy milyen érzés volt. Erre elég sokan elárulták, hogy igazából tök jó, mert végre elmondhatták a véleményüket, végre kimondhatták, ami a szívüket nyomja. Az adatfelvétel szempontjából nagyon előnyös, ha könnyen megnyílnak, ezáltal a válaszadási hajlandóság nálunk – mondjuk így – az iparági átlagnál picivel magasabb, és azt gondoljuk, hogy még tovább tudjuk emelni. Összességében az a helyzet, hogy az emberek bizonyos érzékeny témákban valamivel szívesebben beszélnek egy robottal, mint egy másik emberrel.

- Ez valahol meglepő. Óhatatlanul eszünkbe juthat a robotaxi, amitől sokan tartanak. Igaz, ott a fizikai biztonságunk múlik az AI-n, míg egy közvélemény-kutatásban erről nincs szó, de akkor is: a bizalmunkba kell fogadni egy robotot.

- Nem egy barátom van, aki az AI-iparban dolgozik, és azt mondja, ő bizony be nem ülne egy robotaxiba, amit soha nem értek, hiszen tudjuk, hogy az önvezető autók összességében sokkal biztonságosabban vezetnek, mint az átlagos emberek. Ha a statisztikát nézzük, akkor az önvezető autók nagyságrendekkel kevesebb baleset részesei, mint az emberi sofőrök. De ettől még igaz az, hogy az emberek a gépekben, vagy az AI-ban nem feltétlenül bíznak. A közvélemény-kutatás viszont egy sokkal lazább, sokkal súlytalanabb szituáció: az AI kérdéseket tesz föl, én pedig válaszolok. Ha nem leszek ideges attól, hogy nem érti, amit mondok, vagy hogy rendre visszakérdez, akkor majdhogynem mindegy, hogy ember, vagy robot a kérdező. Ráadásul egy jó, az emberitől nem nagyon elütő beszédhang ezen csak segíteni tud.

- Azt állítjátok, hogy pontos és torzításmentes eredmény várható ezektől a kutatásoktól, de ezt hogyan tudjátok garantálni? Van egy forgatókönyv, amit az AI-nak szóról szóra követnie kell, vagy ennél megengedőbb a rendszeretek, és az AI eltérhet a megadott szövegtől?

- A kérdéseket szó szerint olvassa fel a rendszer, nem improvizál. Magyarul azon az oldalon, hogy a felmérés során mit mond, egyáltalán nincs nagy nyelvi modell, vagy arra bármilyen módon hasonlító generatív AI megoldás. És ez nem véletlenül van így: nem megengedhető az, hogy akár csak szavak szintjén eltérés legyen két embernek feltett kérdéssor között.

A kérdésed értelmében: az egész rendszer mentes a „hallucinációtól”, de ami a mi oldalunkon, az értékeléskor egy picivel bonyolultabbá teszi a dolgot, az az, hogy ott már van nagy nyelvi modell, pontosabban generatív AI használat, hiszen nem meghallgatjuk a válaszokat, hanem leiratozó modellel szöveget készítünk belőlük. Ez még mindig nem okoz hallucinációt, de lehet, hogy rosszul ért valamit, és esetleg mást ír le, mint amit a résztvevőnk mondott. Ez elő is fordul, de körülbelül csak akkora arányban, mint az emberi kérdezőbiztosoknál. Ezt viszont érdemes megérteni. Ilyenkor van az, hogy a választ – miután leiratoztuk – egy nagy nyelvi modell segítségével úgymond megértjük, értelmezzük, kvázi lefordítjuk. Ha valaki azt mondta az eldöntendő kérdésre, hogy „inkább igen, mint nem”, akkor ebből csinálunk egy igent, és ez alapján megyünk tovább. Itt lép be a nagy nyelvi modell, de ugye a nagy nyelvi modellek rendkívül jók abban, hogy összefoglaljanak szövegeket, szóval nagyon-nagyon alacsony a hiba valószínűsége.

- Milyen új típusú adatokat vagy összefüggéseket lehet feltárni az általatok alkalmazott AI-alapú módszerrel, amit a hagyományos kutatások esetleg nem mutatnak ki? Ebből a szempontból vannak-e markáns különbségek?

- Nem hiszem, hogy vannak ilyenek, de azért árnyaljuk egy kicsit ezt a kérdést. Azt gondolom, hogy amit egy emberi kérdezőbiztos meg tud kérdezni, és aztán egy emberi elemző ki tud elemezni, azt meg tudja csinálni az AI is. Az viszont más kérdés, hogy a már kódolt, tehát bizonyos szintig értelmezett, vagy inkább formalizált adatbázisból milyen következtetéseket tudunk levonni. Az AI ebben tud segíteni, de nem csak nekünk, hanem az elemzőknek is. Tehát ebben nincs különbség. Ami egy kicsit más, az az, hogy nyílt kérdést is fel tudunk tenni, magyarul nem csak előre megadott válaszokat tudunk fogadni, mint az, hogy „igen/nem”, vagy „teljesen egyetértek”, „inkább egyetértek” stb. Van olyan kérdés is, hogy „jellemezze az adott politikust néhány szóval”, vagy „mit gondol arról, hogy Magyarországnak ismét járt űrhajósa a világűrben”. Erre szabadon válaszol a kérdezett személy, és a szöveget, a szabadon elmondott választ AI-val tudjuk értelmezni. Ez a nagy nyelvi modell másik belépőpontja: jelentés alapján kategóriákba soroljuk a válaszokat. Megmutatjuk az összes szabad szöveget a nagy nyelvi modellnek, ami kielemzi, hogy milyen jellemző kategóriák voltak a válaszok között, és a válaszokat be is sorolja valamelyik kategóriába. Ezt ugyancsak el tudja végezni egy emberi elemzőkkel dolgozó kutatócég, de csak hosszú idő alatt.

Tehát az idő az, amiből sokat tudunk spórolni az AI alkalmazásával. Hogy aztán az ily módon bekódolt, tehát mondjuk formálisan jobban kezelhető vagy jobban elemezhető adatokban mit találunk, abban az AI szintén nagyon sokat tud segíteni, de pontosan annyira, amennyire bármilyen adattudománnyal foglalkozó, adatelemzéssel foglalkozó szakember.

- A júliusban végzett, magyar politikai közhangulatot mérő kutatásotokról azt nyilatkoztátok, hogy nem tekinthető reprezentatívnak, és az eredmények különböző súlyozásokkal jött ki. Miért volt szükség ezekre a súlyozásokra, mennyire lehetett vele korrigálni a mintavételi torzulásokat?

- Ezzel belemegyünk a telefonos közvélemény-kutatások legzűrösebb és legfejvakarósabb részébe, amivel az egész szakma küzd, úgyhogy nagyon óvatos leszek, mert nem akarok senkit megbántani. Az van, hogy a reprezentativitás első körben azt jelenti: minden ember teljesen egyforma eséllyel kerülhet bele a mintába. Ez a reprezentativitás feltétele, és egyébként a reprezentativitástól azt várjuk, hogy a minta tükrözze az alapvető demográfiai megoszlások szerinti arányokat. Tehát ami a népességben igaz mondjuk a kormegoszlásra, az a kormegoszlás legyen igaz a mintára is. A hazai közmegegyezés szerint nálunk körülbelül 1000 fős minta már elegendő ahhoz, hogy reprezentáljunk 9-10 millió embert. Akkor viszont, ha összeállítunk egy ilyen mintát, akkor azok lesznek benne, akik hajlandóak válaszolni, és ez bizonyos értelemben már nem az átlagot képviseli, hiszen az átlag egyébként nem hajlandó válaszolni.

Aztán: a közvélemény-kutatók különféle módszerekkel igyekeznek korrigálni, hogy a végső minta mégiscsak jobban reprezentálja a lakosságot. Ez a korrekció sokféle lehet, például ott a kvótázás, ami azt jelenti, hogy hívogatjuk az embereket, és amikor már beszéltünk a kormegoszlás szerinti aránynak megfelelő számú 60 évessel, akkor többet nem veszünk fel a mintába. Ez lehet egy irány, de lehet az is, hogy túlkérdezzük a mintanagyságot, és abból már kijönnek a megfelelő arányok. És olyat is szoktak csinálni a profi közvélemény-kutatók, hogy mindenféle kérdést tesznek fel, amelyek konkrét rákérdezés nélkül sorolják be az embereket bizonyos klaszterekbe, és ezeknek a kérdéseknek a használatával készítik el a súlyozást.

- Mondanál erre egy magyar példát?

- Például az, hogy az ember kormánypárti vagy ellenzéki szavazó, meglehetősen nagy korrelációt szokott mutatni azzal a kérdéssel, hogy „támogatja-e az egyneműek házasságát vagy sem”. Tehát, ha valaki nem mondja meg, hogy kire fog szavazni, de elárulja, hogy nem támogatja az egyneműek házasságát, akkor be lehet tippelni, hogy kormánypárti szavazó. Ilyesmire kell gondolni. De súlyozás az is, ha a 60+-os válaszadók aránya nem éri el a kívánt 40 százalékot, csak 37-et, akkor a 60+-osok válaszait megfelelő aránnyal felszorozzák. Pár százalékos differenciát még lehet így korrigálni, és nem fog sérülni a reprezentativitás. Megjegyzem: az a tapasztalat, hogy az idősebbek sokkal inkább hajlandóak felvenni egy ismeretlen számot, és aztán sokkal inkább hajlandóak beszélni a kérdezővel, szóval az idős korosztály rendre felülreprezentált ezekben a mintákban.

- Laikusként is azt feltételeznénk, hogy az idősekhez képest az aktív korú emberek kevésbé hajlandóak időt szánni a nem szorosan a magánéletükhöz vagy a munkájukhoz szükséges telefonhívásokra. Az ő válaszadási hajlandóságukat növelheti, ha AI-val beszélgethetnek a kutatás során?

- Kicsit növeli, de azért nem számottevően. Éppen ezért a kormegoszlás eléggé más volt a mi mintánkban, sőt, túlságosan is: több volt az idős válaszadó annál, hogy ezt egy sima súlyozással korrigálni lehetett volna. Pontosabban: lehetett volna korrigálni, de arra már egy rendes statisztikus azt mondja, hogy ez így nem reprezentatív. Ezért választottunk olyan módszert, amivel ezen javítani lehet: havonta feltesszük ezer embernek ugyanezeket a kérdéseket. Eddig két kutatásunk volt, de jön a következő szeptemberben. Amikor már megvan három hónap, és ott ugyanazokat a trendeket tapasztaljuk, akkor már lehet azt mondani, hogy egy minta a hagyományos statisztikai értelemben ugyan nem reprezentatív, de a három minta együtt már igen.

- Milyen más adatfelvételi csatornák jelenhetnek meg a jövőben a telefonoson kívül? Online vagy valamilyen hibrid kutatási formába bevonható-e az az AI megoldás, amit alkalmaztok?

- Bevonható, és gondolkodunk is rajta, de hangsúlyozzuk, hogy mi alapvetően nem akarunk kutatóintézet lenni. Amikor kutatásokat csinálunk a saját szakállunkra, és egyelőre ez a helyzet, akkor az eredményeket közzétesszük a weboldalunkon, ahonnan bárki le tudja tölteni a válaszok adatbázisát, az elemzést és a módszertani leírást is.

A lényeg, hogy szuper jó, reprezentatív közvélemény-kutatásokat közöljünk a nyilvánossággal, és infrastruktúrát biztosítsunk olyanoknak, akik hatékonyabban akarják elvégezni a telefonos közvélemény-kutatásukat. És ehhez az infrastruktúrához nagyon izgalmas lenne hozzáadni – és ebben gondolkodunk csak igazán – az online felületet. Akár úgy, hogy Viber vagy Messenger hívásban történjen egy ilyen beszélgetés, akár úgy, hogy egy újságcikk alján induljon el, egy linkre kattintva. De ott van az a lehetőség is, hogy ha valakinek egyébként volna kedve beszélgetni, de csak később, amikor például egy órán keresztül kocsiban lesz, akkor online helyzetben tudjon visszahívást kérni egy neki megfelelő időpontra. Ezek izgalmasabb dolgok, és ilyenekkel tervezünk is előállni, de a Minerva Intézetet csak idén nyáron alapítottuk, úgyhogy sok mindent ki kell még próbálnunk. Sok mindent el fogunk vetni, míg más dolgokat megtartunk.

- Azok alapján, amit eddig tapasztaltatok, milyen jövőt jósolsz az AI-nak a közvélemény-kutatások jövőjében Magyarországon?

- Általában is látszik, hogy a beszédalapú kommunikációnak van egyfajta újjászületése az AI-nak köszönhetően. A Sirivel vagy a Google Asszisztenssel is tudunk beszélgetni, a 18 éves gyerekeimen pedig azt látom, hogy inkább beszélgetnek a ChatGPT-vel, mintsem hogy gépeljenek. Szóval az élő beszédnek van egyfajta új felívelése, és egészen biztos, hogy ez a közvélemény-kutatásokban is opció lesz. Ráadásul fontos opció, mert ugyan ki szeretne húsz mondatot leírni egy kérdésre arról, hogy mit gondol egy világpolitikai helyzetről, miközben egy beszélgetésben lehet, hogy szívesen elmondja?

Mert megszervezni egy kutatást: kérdezőbiztosok tucatjait munkára, telefonálásra, visszahívásra, többszöri visszahívásra bírni, az sokkal nehezebb, mint egy szoftvernek megmondani, hogy hívd fel ezt az ezer számot és kérek belőle ezer eredményt. Az élő beszéd egyébként nem kis részben az AI-nak köszönhetően jön vissza, hiszen egy sokkal természetesebb kommunikációs felület, mint az írás, a gépelés, sokkal naturálisabb forma, így sokat fog segíteni az AI a közvélemény-kutatóknak is.